Chimica appunti parte 1

Chimica appunti parte 1

Questo sito utilizza cookie, anche di terze parti. Se vuoi saperne di più leggi la nostra Cookie Policy. Scorrendo questa pagina o cliccando qualunque suo elemento acconsenti all’uso dei cookie.I testi seguenti sono di proprietà dei rispettivi autori che ringraziamo per l'opportunità che ci danno di far conoscere gratuitamente a studenti , docenti e agli utenti del web i loro testi per sole finalità illustrative didattiche e scientifiche.

Teoria atomica e leggi quantitative

L’Universo è composto di materia ed energia, due aspetti della medesima entità visto che, come dimostrò Einstein, esse possono convertirsi l’una nell’altra secondo la relazione E = mc2.

La chimica è la scienza che studia le caratteristiche, la struttura e le trasformazioni della materia e gli scambi energetici connessi a tali trasformazioni.

Oggi noi possediamo un modello sufficientemente dettagliato per descrivere la struttura della materia, il modello atomico. Parlare di atomi è attualmente quasi un fatto scontato, ma il modello atomico si affermò con difficoltà, nonostante sia stato proposto per la prima volta più di duemila anni fa.

La struttura della materia: atomi ed elementi

Le prime ipotesi sulla struttura e sulla natura della materia vennero infatti avanzate, agli albori del pensiero occidentale, in Grecia. A tal proposito possiamo individuare, in estrema sintesi, due problemi fondamentali intorno ai quali si sviluppò il dibattito filosofico su questo tema:

A) continuità/discontinuità della materia: l’atomo

Da una parte Aristotele che ipotizza l'esistenza di una materia continua, divisibile indefinitamente in frammenti sempre più piccoli e quindi irriducibile ad unità elementari.

due correnti di pensiero che interpretavano la materia in modi diametralmente opposti.

Dall’altra Democrito di Abdera (IV sec a.C.), anche se il primo ad avere parlato di atomi fu Leucippo,

che ritiene invece la materia discontinua e sostiene pertanto l'esistenza di particelle minuscole, chiamate atomi , invisibili, incorruttibili ed eterne.

Le idee di Democrito sopravvissero nei secoli. Furono divulgate da Epicuro di Samo (III sec. a.C.) e, nel mondo latino, da Tito Lucrezio Caro (95-55 a.C.) nel "De Rerum Natura".

B) complessità/semplicità della materia: l’elemento

La ricerca dell'arche, del 'principio primo’, dal quale discendeva tutta la molteplicità dell'essere, rappresentò forse l'elemento peculiare della prima speculazione greca intorno al mondo. Il problema di poter ricondurre l'enorme varietà di sostanze conosciute alla combinazione di poche sostanze semplici significava fondamentalmente razionalizzare il mondo e quindi “spiegare” i fenomeni complessi riconducendoli e riducendoli alla loro composizione elementare.

A parte i primi tentativi effettuati in tal senso dai primi 'Fisiologi' presocratici, come Talete (624-546 a.C.) che individuò nell'acqua il principio primo o Anassimene (586-528 a.C.) che lo identificò nell'aria, l'ipotesi che ebbe la maggior fortuna durante tutto il medioevo, grazie all'autorevole consenso di Aristotele, fu senza dubbio quella di Empedocle (490-430 a.C.). Secondo tale ipotesi tutta la materia era composta da quattro sostanze fondamentali ed elementari: l'aria, l'acqua, la terra e il fuoco.

Il concetto di atomo e di elemento sono fondamentali in chimica. Le prime definizioni moderne si devono a Boyle e a Newton.

Per R.Boyle (1627-1691) gli elementi sono "corpi primitivi, semplici, incontaminati, che, non essendo costituiti da altri corpi o di loro mescolanze, sono ingredienti di cui i corpi misti sono costituiti e nei quali questi possono essere in definitiva risolti".

Mentre Newton immaginò gli atomi come minuscole sfere, dominate solo da forze attrattive e repulsive.

In Opticks così scrive: "In principio Dio creò la materia in particelle mobili, impenetrabili, dure, massicce, solide...."

Oggi la nostra idea di atomo è notevolmente cambiata rispetto al modello newtoniano, ciononostante vi sono ambiti della chimica e della fisica moderna (teoria cinetica dei gas, ad esempio) in cui tale modello risulta essere ancora perfettamente adeguato ed in grado di giustificare alcuni comportamenti della materia.

La chimica moderna, che nasce tra la fine del ‘700 e l’inizio dell’800, giunge ad unificare il concetto di atomo e di elemento. Tale unificazione si produce con la formulazione da parte di Dalton della Teoria atomica, che possiamo così sintetizzare

- La materia è composta di atomi indivisibili ed inalterabili;

- Esistono atomi con caratteristiche differenti. Tutti gli atomi di uno stesso tipo costituiscono le sostanze semplici o elementi;

- Le trasformazioni chimiche si producono per unione o separazione di atomi secondo rapporti rigorosamente determinati e caratteristici per ogni sostanza chimica.

La teoria atomica è stata in seguito sostanzialmente confermata ed è a tutt’oggi uno dei paradigmi della chimica. In natura esistono 90 tipi di atomi che individuano altrettanti elementi chimici (gli elementi fino all’Uranio sono 92, ma il 43mo (Tc Tecnezio) ed il 61mo (Pm Promezio) sono prodotti artificialmente). Tuttavia oggi gli atomi non sono più considerati strutture elementari ed “indivisibili”. Essi sono infatti composti da tre tipi di particelle subatomiche: il protone, il neutrone e l’elettrone.

Il protone, con carica elettrica positiva, ed il neutrone, privo di carica elettrica, vanno a formare la parte centrale dell’atomo, detta nucleo. Gli elettroni, con carica elettrica negativa, uguale e contraria a quella dei protoni, orbitano intorno al nucleo. Un atomo è neutro quando i protoni del suo nucleo sono esattamente neutralizzati da un ugual numero di elettroni. Gli atomi che presentano elettroni in più o in meno rispetto ai protoni del nucleo risultano elettricamente carichi e sono detti ioni. Se vi è un difetto di elettroni essi risultano caricati positivamente (cationi), viceversa presentano una carica negativa (anioni).

Simbologia chimica

Agli inizi dell’800 erano già stati identificati una cinquantina di elementi chimici che il chimico svedese J.J. Berzelius (1779 – 1848) raccolse nel 1818 in una tabella. Lo stesso Berzelius propose di adottare la simbologia chimica attualmente in uso.

Ciascun elemento chimico viene univocamente associato ad un simbolo, in genere corrispondente all’iniziale del suo nome latino (o alle prime due lettere se vi è possibilità di equivoco con altri elementi). Ad esempio C è il Carbonio, Ca il Calcio, Ce il Cerio, Co il Cobalto, Cu il Rame.

I simboli rappresentano sia gli elementi che i relativi atomi. Così N rappresenta l’elemento Azoto, ma anche un atomo di Azoto. In questo modo è possibile rappresentare le sostanze chimiche mediante opportune scritture convenzionali, dette formule.

Nelle formule grezze (o brute) sono rappresentati i simboli degli elementi chimici che costituiscono la sostanza, ciascuno seguito in basso a destra da un numero, detto indice, che specifica quanti atomi di quell’elemento sono presenti. L’indice 1 non compare, essendo sottinteso.

H2SO4 CO2 H2O N2 Na2CO3 O2 Mg(NO3)2

Come si può osservare dalle formule che le rappresentano, le sostanze chimiche possono essere costituite da atomi di uno stesso elemento (O2 N2) e sono perciò dette sostanze elementari, o da atomi di elementi diversi (H2SO4 CO2) e sono perciò dette sostanze composte o, semplicemente, composti.

I composti sono sostanzialmente di due tipi: molecolari o ionici.

Un composto molecolare è formato da molecole. Una molecola è la più piccola parte di materia che presenta le medesime caratteristiche chimiche della sostanza alla quale appartiene. È costituita da un gruppo definito di atomi, tra loro legati, ma distinti e separati dagli atomi che costituiscono altre molecole. Le formule che rappresentano tali composti sono dette formule molecolari.

Un composto ionico è costituito dall’alternarsi di anioni e cationi legati dalla reciproca attrazione elettrostatica e presenti in rapporti precisi, definiti dalla loro carica. Ad esempio nel carbonato di sodio si alternano ioni Na+ e ioni CO32- nel rapporto di 2:1, necessario per neutralizzare le cariche elettriche. La formula Na2CO3 non rappresenta la molecola, che non esiste in quanto tale, ma descrive il minimo rapporto di combinazione tra gli elementi. Tali formule sono dette formule minime.

Gli ioni presentano, ad esponente del simbolo che li rappresenta, il numero di cariche, positive o negative che li caratterizza, esattamente pari al numero di elettroni persi o acquistati.

Esistono anche ioni poliatomici.

Le formule grezze (sia molecolari che minime) non danno alcuna informazione sul modo in cui gli atomi sono legati (connettività). A questo scopo sono state introdotte rappresentazioni, dette formule di struttura. Nel caso si desiderino evidenziare anche informazioni relative alla disposizione nello spazio degli atomi e dei loro legami è necessario utilizzare formule spaziali o steriche, le quali, oltre ad evidenziare la posizione dei legami, mostrano anche la loro orientazione (angolo di legame) e danno quindi informazioni sulla struttura tridimensionale (geometria) della sostanza

Nelle formule spaziali (o steriche) valgono le seguenti convenzioni

Nelle trasformazioni chimiche, comunemente dette reazioni chimiche, le sostanze messe a reagire, dette reagenti, si trasformano in altre specie chimiche, dette prodotti di reazione. Ciò avviene essenzialmente perché alcuni legami che tenevano uniti gli atomi nelle sostanze reagenti si spezzano e si riformano secondo nuove combinazioni. Le nuove configurazioni atomiche che si generano costituiscono i prodotti finali della reazione.

Ovviamente durante tali trasformazioni il numero totale di atomi di ciascun elemento chimico non varia, anche se si trova diversamente combinato nei prodotti rispetto ai reagenti (principio della conservazione della materia).

Una reazione chimica viene simbolicamente rappresentata mediante un’equazione chimica. A primo membro troviamo le formule dei reagenti, mentre a secondo membro le formule dei prodotti di reazione, tutte separate dal segno di addizione (+). Il segno di eguaglianza tra i due membri (=) viene sostituito dalla freccia di reazione (®), se la reazione si completa e tutti i reagenti si trasformano nei prodotti o dalla doppia freccia di reazione ( ), se si tratta di un equilibrio chimico e la reazione forma una miscela in equilibrio di reagenti e prodotti.

), se si tratta di un equilibrio chimico e la reazione forma una miscela in equilibrio di reagenti e prodotti.

Coefficienti stechiometrici e bilanciamento

Affinché l’equazione descriva la reazione non solo dal punto di vista qualitativo (quali specie chimiche sono coinvolte nella reazione), ma anche quantitativo, è necessario anteporre a ciascuna formula un numero intero, detto coefficiente stechiometrico, che specifichi il numero di molecole di ciascuna specie chimica che partecipano alla reazione.

La determinazione dei coefficienti stechiometrici costituisce il bilanciamento della reazione.

Bilanciare una reazione significa dunque calcolare opportuni coefficienti per i quali è necessario moltiplicare le formule delle specie chimiche che partecipano alla reazione, affinché ogni elemento compaia a sinistra e a destra del segno di reazione con il medesimo numero di atomi. In altre parole una reazione è bilanciata quando soddisfa il principio di conservazione della materia.

Per bilanciare una reazione non vi sono regole precise, ma in genere è opportuno seguire i seguenti consigli:

- Si pareggiano inizialmente gli atomi di elementi che compaiono in un minor numero di specie chimiche (in genere l’ossigeno e l’Idrogeno sono molto diffusi e si bilanciano rispettivamente per ultimo (O) e penultimo (H));

- Se, bilanciando un elemento, si modifica qualche altro elemento, si procede subito al suo bilanciamento

Esempio Iniziamo bilanciando il ferro: Fe2(CO3)3 + HNO3 ® 2Fe(NO3)3 + H2CO3 in tal modo abbiamo modificato anche il numero di atomi di azoto tra i prodotti di reazione che ora sono 6. Poiché tra i reagenti vi è un solo atomo di azoto, poniamo un coefficiente "6" davanti all'acido nitrico HNO3 Fe2(CO3)3 + 6HNO3 ® 2Fe(NO3)3 + H2CO3 Ora sia il ferro che l'azoto sono bilanciati. Bilanciamo il carbonio. Vi sono 3 atomi di carbonio tra i reagenti e 1 tra i prodotti di reazione. Poniamo quindi un coefficiente "3" davanti all'acido carbonico Fe2(CO3)3 + 6HNO3 ® 2Fe(NO3)3 + 3H2CO3 Verifichiamo l'idrogeno. 6 atomi tra i reagenti, 6 atomi tra i prodotti di reazione. L'idrogeno è bilanciato. |

Una volta che l'equazione è bilanciata siamo in grado di effettuare considerazioni di tipo quantitativo sulla reazione.

Nel caso della reazione appena bilanciata possiamo ad esempio affermare che una molecola di carbonato ferrico Fe2(CO3)3 necessita di 6 molecole di acido nitrico HNO3 per reagire e che da tale reazione si producono 2 molecole di nitrato ferrico Fe(NO3)3 e 3 di acido carbonico H2CO3.

Esempio |

Gran parte dei concetti fin qui esposti (atomo, molecola, sostanze elementari e composti, reazione chimica e relativo bilanciamento) sono stati definiti agli albori della chimica moderna ed hanno contribuito alla sua fondazione.

Le prime leggi della chimica

Le prime leggi della chimica risalgono alla fine del 700 e formalizzano alcuni comportamenti regolari che si iniziano a scoprire nei rapporti di combinazione tra le sostanze che reagiscono. Le regolarità osservate nel comportamento della materia durante le reazioni vennero espresse attraverso una serie di leggi quantitative che costituirono i presupposti alla formulazione della stessa teoria atomica.

Legge della conservazione della massa di Lavoisier (1789)

"In una reazione chimica, la somma dei pesi dei reagenti è sempre uguale alla somma dei pesi dei prodotti di reazione".

Essa afferma che la materia non si crea e non si distrugge. Tale legge, che oggi sembra ovvia, non lo era affatto al tempo in cui venne formulata.

La combustione, ad esempio, in cui materiali come il legno o la carta, perdono apparentemente peso durante il processo sembrava confermare la tesi opposta. Gli stessi fenomeni di fusione dei metalli in cui si producevano scorie, dette allora calci, più pesanti dei metalli stessi ponevano grossi problemi interpretativi.

Nel 1715 il chimico tedesco G.E.Stahl aveva introdotto il concetto di flogisto o principio infiammabile per giustificare questo strano comportamento.

Lavoisier riuscì a fare definitivamente chiarezza su questi e molti altri problemi. Egli viene oggi considerato il primo vero chimico sperimentale ed il fondatore della chimica moderna.

Il suo lavoro è infatti caratterizzato dalla rigorosa applicazione di strumenti di misura e del metodo sperimentale alla pratica di laboratorio.

Pesando accuratamente reagenti e prodotti di reazione, Lavoisier dimostrò che le calci (oggi si chiamerebbero ossidi) derivate dalla fusione dei metalli all'aria, pesano di più dei metalli di partenza perché sono combinazioni del metallo con l'ossigeno atmosferico, portando al definitivo abbandono della teoria del flogisto

Per ciò che riguarda la comprensione della natura e della struttura della materia i risultati ottenuti da Lavoisier rappresentano un notevole passo in avanti, suggerendo la possibilità che durante le reazioni chimiche le sostanze non 'spariscano', ma semplicemente si combinino in vario modo per dare sostanze aventi diverse proprietà, ma massa complessivamente uguale.

Lavoisier riuscì in definitiva a dimostrare che il peso dei corpi semplici (elementi) può ritrovarsi inalterato nelle loro combinazioni in corpi composti. E, viceversa, che i corpi composti possono spezzarsi in elementi più semplici aventi complessivamente lo stesso peso.

Legge delle proporzioni definite e costanti (Proust 1799)

"In un determinato composto chimico gli elementi che lo formano stanno tra loro in proporzioni di peso definite e costanti".

Ad esempio per ottenere acqua dobbiamo sempre far reagire Idrogeno ed Ossigeno nelle proporzioni di 1 g contro 8 g. Qualsiasi eccesso di uno dei due elementi rispetto a tale rapporto, non reagisce per dare acqua e rimane inalterato alla fine della reazione.

Tale legge venne aspramente criticata dal chimico francese Berthollet (1748-1822), il quale riteneva che la composizione chimica di un composto non fosse percentualmente fissa e definita, ma dipendesse dal modo in cui il composto stesso veniva preparato.

Anche la legge di Proust (1754-1826) suggeriva fortemente, come quella di Lavoisier, la possibilità che ogni elemento chimico fosse costituito da particelle aventi una massa caratteristica, in grado di unirsi tra loro solo in proporzioni fisse.

Legge delle proporzioni multiple (Dalton 1803)

Quando due elementi si combinano tra loro per dare più di un composto, le quantità in peso di uno che si combinano con una quantità fissa dell'altro stanno tra loro in rapporti esprimibili mediante numeri interi, in genere piccoli .

Dalton intuì che solo immaginando la materia formata da particelle microscopiche, indivisibili, indistruttibili e non creabili (quindi stabili), si potevano spiegare i rapporti di combinazione degli elementi chimici nel dare i composti.

La teoria atomica venne enunciata ufficialmente da Dalton solo nel 1808. naturalmente essa aveva bisogno di altre conferme sperimentali. Soprattutto, implicando che ogni elemento fosse formato da atomi aventi una massa caratteristica, richiedeva che fossero calcolati i pesi dei diversi atomi.

Tutti i dati sperimentali fino ad allora ottenuti non erano certo in grado di dimostrare l'esistenza degli atomi, ma potevano facilmente essere spiegati se si accettava il modello atomico.

Come spesso accade il modello dovette ben presto subire una parziale revisione ed essere modificato per render conto di nuovi dati sperimentali che emergevano dallo studio delle reazioni gassose.

Fino alla metà del '700 i gas , ed in particolare l'aria, non venivano concepiti come sostanze chimicamente attive, ma semplicemente come un mezzo amorfo, un substrato fluido che occupava lo spazio vuoto. Nella seconda metà del '700 i chimici iniziano ad isolare i primi gas: nasce la chimica pneumatica.

Nel 1755 J.Black (1728-1799) annuncia la scoperta di un gas diverso dall'aria che egli chiama aria fissata (anidride carbonica). Nel 1766 H.Cavendish (1731-1810) comunica alla Royal Society la scoperta dell'aria infiammabile (Idrogeno), ottenuta facendo reagire metalli con acidi . Nel 1784 riuscì a dimostrare che il prodotto della combustione dell'aria deflogisticata (ossigeno) con aria infiammabile (Idrogeno) era l'acqua.

Priestley (1733-1804) dimostrò che i vegetali sono in grado di risanare l'aria fissata (anidride carbonica) prodotta dalla combustione delle candele o dalla respirazione animale. A lui si deve anche la scoperta dell'ossigeno . Solo dopo la pubblicazione dei lavori di Priestley e di Lavoisier sull'ossigeno divennero noti in Europa i lavori del chimico svedese C.W.Scheele, che scoprì l'ossigeno indipendentemente nel 1755.

Legge dei rapporti volumetrici gassosi definiti e costanti (Gay Lussac 1808)

I volumi delle specie chimiche gassose che partecipano ad una reazione stanno tra loro sempre in rapporto numerico semplice.

Ad esempio nelle seguenti reazioni:

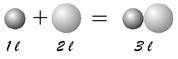

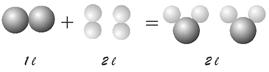

1 litro di Ossigeno + 2 litri di Idrogeno = 2 litri di vapor d’acqua

La teoria atomica daltoniana che spiegava bene la legge di Proust delle proporzioni multiple e definite, non era tuttavia in grado di spiegare le regolarità incontrate dai Gay-Lussac (1778-1850) nello studio delle reazioni gassose.

Infatti, partendo dal presupposto che anche i gas siano costituiti da atomi, la teoria atomica può cercare di giustificare i risultati ottenuti da Gay-Lussac in due modi:

- il volume è proporzionale alla massa degli atomi

Il volume che occupa 2 litri è costituito da particelle di massa doppia rispetto a quello che occupa 1 litro. Secondo questa ipotesi però il gas che si forma, essendo costituito dalla somma delle masse dei gas che si uniscono, dovrebbe occupare un volume pari a 3 litri, in netto contrasto con l'esperienza.

- il volume è proporzionale al numero degli atomi

Il gas che occupa 2 litri è costituito da un numero di particelle doppio rispetto al gas che occupa 1 litro. In tal caso tuttavia per ogni atomo del primo gas che si unisce con 2 atomi del secondo gas si dovrebbe formare una particella del gas finale. Quest'ultimo dovrebbe pertanto occupare un volume pari ad 1 litro.

Così in entrambi i casi l'interpretazione del modello atomico non sarebbe in grado di spiegare il comportamento quantitativo delle reazioni gassose. Fu però sufficiente una piccola modifica alla teoria di Dalton per rendere il modello atomico nuovamente utilizzabile.

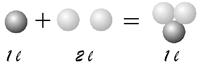

Tale nuova impostazione si deve ad Amedeo Avogadro (1776-1856). Secondo Avogadro volumi uguali di gas diversi nelle stesse condizioni di temperatura e di pressione devono contenere lo stesso numero di particelle. Tali particelle non devono però necessariamente essere elementari (atomi), ma possono anche essere gruppi di atomi (molecole).

In tal modo la reazione gassosa precedente può essere scritta così:

O2 + 2H2 ® 2H2O

Se ne deduce che l’Ossigeno e l’Idrogeno devono essere costituiti non da atomi singoli, ma da molecole biatomiche e che l’acqua è una molecola triatomica formata da 2 atomi di Idrogeno ed 1 di Ossigeno.

L'ipotesi di Avogadro, che poi si rivelò esatta, fu però osteggiata da atomisti illustri e solo nel 1858, Stanislao Cannizzaro (1826-1910) ne verificò definitivamente la validità attraverso una serie di esperimenti conclusivi.

La teoria atomico-molecolare, così come era stata proposta da Avogadro, apriva la strada alla possibilità di pesare atomi e molecole, fatto questo che avrebbe portato ulteriori conferme all'esistenza degli atomi stessi.

Pesi atomici e molecolari relativi: l’unità di massa atomica

Se infatti volumi uguali di gas diversi nelle stesse condizioni di T e P contengono lo stesso numero di molecole, il rapporto tra il peso di due volumi uguali di gas diversi deve essere uguale al rapporto tra i pesi delle loro molecole. Naturalmente occorreva fissare il peso molecolare di un gas di riferimento rispetto al quale pesare tutti gli altri.

Venne scelto l'idrogeno, alla cui molecola biatomica venne assegnato un peso molecolare convenzionale pari a 2. In tal modo vennero calcolati i pesi atomici e i pesi molecolari relativi Pr all'idrogeno di molte sostanze. Nella prima metà dell'Ottocento, soprattutto ad opera di Berzelius (1779-1849), se ne conoscevano qualche migliaio.

Preso un volume fisso di un gas generico A avente peso WA ed un ugual volume di idrogeno avente peso  = 2, il peso molecolare relativo cercato (PrA) sarà dato dalla seguente proporzione:

= 2, il peso molecolare relativo cercato (PrA) sarà dato dalla seguente proporzione:

In effetti sarebbe più corretto parlare di massa atomica o molecolare relativa (mr) e non di peso. Si ricordi infatti che mentre la massa è una caratteristica costante di un corpo materiale , il suo peso dipende dal luogo in cui si misura, essendo il peso la forza di reciproca attrazione tra il corpo ed il pianeta (o in generale il corpo celeste) sul quale giace. Tuttavia, applicando la seconda legge della dinamica (f = ma), si osserva che il peso è direttamente proporzionale alla massa del corpo (P = mg), nell’ipotesi che l’accelerazione di gravità g sia costante su tutto il pianeta (ipotesi accettabile solo in prima approssimazione).

In chimica resta comunque molto diffusa l’abitudine di parlare di pesi atomici e di pesi molecolari, anche se ormai molti testi utilizzano più correttamente il termine ‘massa’.

Oggi non si usa più l’Idrogeno come unità di misura per pesare (massare) le sostanze, ma 1/12 della massa del Carbonio 12 (l’atomo di carbonio con un nucleo formato da 6 protoni e 6 neutroni ). Tale quantità è nota come unità di massa atomica (uma o u).

L’unità di massa atomica vale

1 u = 1,660 538 782 10-24 g

Utilizzando dunque come fattore di conversione (approssimato) 1,6605 10-24 g/u è possibile trasformare i pesi relativi (espressi in u) in pesi assoluti (espressi in g).

Pa (g) = Pr (u) 1,6605 10-24 (g/u)

Ad esempio il peso atomico assoluto del Carbonio 12 è Pa C = 12 (u) 1,6605 10-24 (g/u) = 1,9926 10-23 (g) |

Nuclidi: numero atomico Z e numero di massa A

Nella seconda metà dell'Ottocento la scoperta di nuovi elementi chimici e lo studio delle loro proprietà, sia fisiche che chimiche, rese evidente l'esistenza di regolarità all'interno dei diversi tipi di atomi.

Vi furono molti tentativi di classificare e raggruppare gli elementi in funzione delle loro caratteristiche.

Il risultato di maggior rilievo in questa direzione fu senz'altro quello conseguito dal russo D.I. Mendeleev che nel 1869 propose una tavola periodica degli elementi ordinati secondo il peso atomico relativo crescente in periodi (righe orizzontali) e gruppi (colonne verticali). All'interno di uno stesso gruppo venivano collocati gli elementi che presentavano caratteristiche chimiche analoghe.

Fatto notevole della tabella periodica è che alcune caselle lasciate vuote da Mendeleev poiché non esisteva alcun elemento con le caratteristiche previste per quella posizione, vennero in seguito occupate quando l'elemento in questione venne scoperto.

Oggi sappiamo che gli elementi non vanno ordinati secondo il peso atomico crescente, ma secondo il numero crescente di protoni che presentano nel loro nucleo.

Il numero di protoni del nucleo è detto numero atomico Z ed ogni elemento differisce dagli altri per avere un diverso numero atomico che, per gli elementi naturali, può assumere i valori da 1 (Idrogeno) a 92 (Uranio). La classificazione secondo il peso atomico crescente coincide, per la maggior parte degli elementi, con la classificazione effettuata secondo il numero atomico crescente.

Esistono tuttavia 4 coppie di elementi adiacenti (Ar/K Co/Ni Te/I Th/Pa (Torio/Proattinio)) che, se classificati secondo il peso atomico crescente, non si incolonnano correttamente.

Ogni atomo è poi caratterizzato dal numero dei neutroni N del suo nucleo. Protoni e neutroni vengono anche complessivamente indicati con il termine di nucleoni. Il numero di nucleoni di un atomo costituisce il suo numero di massa A (la massa di un atomo è data essenzialmente dal suo nucleo e quindi da protoni e neutroni, in quanto gli elettroni sono circa 3 ordini di grandezza meno massicci di un nucleone). Tra A, Z ed N esiste la seguente ovvia relazione

A = Z + N

Quando ci si riferisce alla composizione nucleare di un atomo, si preferisce indicare quest’ultimo con il termine di nuclìde. Ciascun nuclide viene univocamente individuato dal valore di Z ed A. Un nuclide di un elemento viene rappresentato ponendo il numero atomico Z in basso a sinistra del simbolo dell’elemento ed il numero di massa A (Z + N) in alto a sinistra. Ad esempio il simbolo  (leggi: carbonio sei-quattordici) rappresenta l’isotopo del Carbonio che possiede 6 protoni e 8 neutroni (N = A – Z = 14 – 6 = 8). Visto che il simbolo dell’elemento è in corrispondenza biunivoca con il numero atomico Z quest’ultimo può essere sottointeso e così si può ad esempio scrivere 12C o C-12 per indicare l’isotopo sei-dodici del Carbonio.

(leggi: carbonio sei-quattordici) rappresenta l’isotopo del Carbonio che possiede 6 protoni e 8 neutroni (N = A – Z = 14 – 6 = 8). Visto che il simbolo dell’elemento è in corrispondenza biunivoca con il numero atomico Z quest’ultimo può essere sottointeso e così si può ad esempio scrivere 12C o C-12 per indicare l’isotopo sei-dodici del Carbonio.

Un nuclide di un generico elemento X viene dunque rappresentato

Gli isotopi sono nuclidi di un medesimo elemento chimico (stesso Z) che differiscono per il numero dei neutroni N (ad esempio  (Trizio))

(Trizio))

Il termine isotopo deriva da un termine greco che significa “stesso posto”, in quanto tutti gli isotopi di un medesimo elemento, avendo lo stesso numero atomico Z, occupano lo stesso posto, la stessa casella, nella tabella periodica.

Nuclidi con lo stesso numero di massa A sono detti isòbari ( ad esempio  )

)

Nuclidi con lo stesso numero neutroni N sono detti isòtoni ( ad esempio  )

)

La tabella periodica riporta in ciascuna casella sia il valore del numero atomico Z dell’elemento che il valore del suo peso atomico relativo.

In realtà il peso atomico è la media ponderata (pesata) delle masse dei suoi isotopi. Ogni elemento chimico è presente in natura sotto forma di una miscela dei suoi isotopi, i quali sono però più o meno abbondanti e contribuiscono pertanto in maniera diversa al peso atomico dell’elemento, in proporzione alla loro diffusione percentuale.

Prendiamo ad esempio i due isotopi più diffusi del Cloro, il Cloro-35 ( ). Se essi fossero presenti in natura con le medesime percentuali, il peso atomico relativo medio del Cloro sarebbe di 36 u. In realtà su 100 atomi di Cloro, 75 sono di Cloro-35 e 25 sono di Cloro-37. Per calcolare il peso atomico medio dobbiamo dunque calcolare non una media semplice, ma una media che tenga conto della loro diversa frequenza, del loro diverso ‘peso’ (inteso come importanza), appunto una media ponderata o pesata.

). Se essi fossero presenti in natura con le medesime percentuali, il peso atomico relativo medio del Cloro sarebbe di 36 u. In realtà su 100 atomi di Cloro, 75 sono di Cloro-35 e 25 sono di Cloro-37. Per calcolare il peso atomico medio dobbiamo dunque calcolare non una media semplice, ma una media che tenga conto della loro diversa frequenza, del loro diverso ‘peso’ (inteso come importanza), appunto una media ponderata o pesata.

I pesi atomici relativi che compaiono nella tabella periodica possono essere utilizzati per determinare i pesi molecolari relativi (nel caso di formule minime si parla di peso-formula).

Per determinare il peso molecolare relativo di una sostanza è sufficiente sommare i pesi atomici di tutti gli elementi che compaiono nella formula, ciascuno moltiplicato per il rispettivo indice.

Ad esempio il peso molecolare dell’acido solforico H2SO4 è pari a

La mole ed il Peso molare

Un concetto strettamente correlato al peso relativo e fondamentale in chimica per i calcoli quantitativi è quello di mole. La mole è una delle 7 grandezze fondamentali, definite nel Sistema Internazionale (SI) di unità di misura come quantità di sostanza: simbolo mol.

La mole è una quantità di una sostanza chimica numericamente uguale al suo peso relativo, espresso in grammi anziché in uma (più correttamente andrebbe espressa in kg, ma in chimica è più diffuso l’uso del grammo).

Esempio: calcoliamo quanto vale 1 mole di anidride carbonica CO2. Il peso relativo della CO2 è |

Uno dei problemi pratici che più spesso si pongono nei calcoli chimici quantitativi è trasformare un determinata quantità di sostanza espressa in grammi (W), nel corrispondente numero di moli (n) o viceversa. Per far ciò è ovviamente necessario conoscere il peso di una mole o Peso molare.

Il Peso molare PM (più correttamente Massa Molare) è il peso (massa) di 1 mole e si misura in g mol-1 (più correttamente in kg mol-1).

Il Peso molare di una sostanza rappresenta quindi un fattore di conversione che permette di trasformare una quantità di sostanza espressa mediante il suo peso W, nell’equivalente numero di moli n e viceversa.

Infatti se consideriamo W grammi di una sostanza e vogliamo sapere a quante moli n corrispondono dobbiamo dividere W per il peso di una mole, cioè per il Peso molare.

Esempio: quante moli di acqua sono presenti in 27 mg di H2O |

Viceversa se vogliamo calcolare quanti grammi pesa un determinato numero n moli di una sostanza, sarà sufficiente moltiplicare il numero n di moli per il peso di una mole, cioè per il Peso molare.

Esempio: calcoliamo quanto pesano 3,5 10-2 moli di anidride carbonica CO2. |

Fino a tutto il '600 il fatto che durante il processo di fusione dei metalli all'aria una parte di essi bruciava trasformandosi in scoria simile alla calce (calcinazione), con aumento di peso, non trovava spiegazione. Così come non ci si spiegava come le scorie, scaldate con carbone, riformassero il metallo di partenza, perdendo peso. Stahl ipotizzò dunque l'esistenza di un fluido, detto appunto flogisto, avente la proprietà di togliere peso alla materia che lo conteneva. Sottoponendo il metallo a riscaldamento , il flogisto abbandonava la materia restituendo ad essa peso.

Se prendiamo ad esempio i 4 composti del cloro con l'ossigeno, troviamo che con 71 g di cloro reagiscono rispettivamente 16g, 48g, 80g e 112g di Ossigeno per dare quattro composti tra loro diversi. Si può facilmente verificare che tali pesi stanno tra loro come 1:3:5:7.

Cavendish era però un sostenitore della teoria del flogisto e credeva che l'aria infiammabile fosse liberata dai metalli che perciò considerava corpi composti

In realtà la scoperta dell'ossigeno è controversa in quanto anche Lavoisier pubblicò poco dopo Prestley osservazioni identiche. Ma mentre Prestley era un fautore della teoria del flogisto e considerava l'aria un gas seplice che poteva deflogisticarsi trasformandosi in ossigeno o flogisticarsi trasformandosi in azoto (il miscuglio di aria deflogisticata e flogisticata dava l'aria di partenza), Lavoisier considerava correttamente ossigeno ed azoto due componenti separati dell'aria

Il numero di Avogadro

Si può facilmente verificare che 1 mole di una qualsiasi sostanza contiene sempre lo stesso numero di particelle costituenti (atomi, ioni, molecole etc). Per calcolare tale numero è sufficiente dividere il peso di una mole (Peso molare) per il peso di una particella (Peso molecolare assoluto).

Il Peso molare ed il Peso molecolare relativo sono per definizione numericamente uguali per qualsiasi sostanza. Il loro rapporto vale dunque sempre 1 ed il numero di particelle contenuto in una mole risulta essere il medesimo per ogni sostanza e numericamente pari al reciproco della massa in grammi dell’unità di massa atomica. Tale numero, indicato con NA, è conosciuto come numero di Avogadro.

(si noti che, se si esprime il peso molare in kg/mol, il fattore di conversione a denominatore vale 1,6605 10-27 kg/u ed il numero di particelle per mole risulta essere 1000 volte più elevato)

È allora possibile introdurre una definizione più generale di mole: una mole è una quantità di sostanza contenente un numero di Avogadro di entità costituenti, identiche e numerabili. Così è possibile ad esempio parlare di una mole di elettroni senza far riferimento al loro peso, ma al loro numero ed in definitiva alla loro carica complessiva e quindi ad una certa quantità di carica elettrica (il Faraday = 96.485,34 C).

Esempio: calcolare quante molecole sono contenute in un bicchier d’acqua avente la capacità di 0,135 litri. |

Una conseguenza del principio di Avogadro è che un medesimo numero di moli di una qualsiasi sostanza gassosa devono occupare sempre il medesimo volume (a P e T costanti). Infatti se ‘volumi uguali di gas diversi nelle stesse condizioni di T e P contengono lo stesso numero di particelle’, allora deve anche essere vero che “gas che contengono lo stesso numero di particelle devono occupare lo stesso volume”. Se ne deduce pertanto che 1 mole di un qualsiasi gas, contenendo sempre lo stesso numero di particelle (il numero di Avogadro) deve occupare sempre il medesimo volume ed in particolare, a 0°C e alla pressione di 1 atm occupa un volume pari a 22,414 l, detto volume molare standard.

Calcolo delle quantità che reagiscono

Come abbiamo già avuto modo di dire il concetto di mole è essenziale per semplificare i calcoli quantitativi o stechiometrici. La stechiometria (dal greco stoiceion = elemento, sostanza fondamentale) è quella parte della chimica che si occupa degli aspetti quantitativi delle reazioni ed in particolare dei rapporti numerici e ponderali che intercorrono tra le specie chimiche che reagiscono.

Per poter procedere con i calcoli stechiometrici è necessario che una equazione sia bilanciata.

In un’equazione bilanciata sono già definiti i rapporti numerici tra specie chimiche.

Quando scriviamo l’equazione bilanciata

3H2 + N2 → 2NH3

individuiamo ad esempio il rapporto numerico di reazione tra Idrogeno e Azoto che risulta essere pari a 3:1. Il rapporto tra Idrogeno ed ammoniaca è invece di 3:2 e così via.

Ma i coefficienti stechiometrici non rappresentano solo il numero di molecole, ma anche il numero di moli che reagiscono. Per rendercene conto, dopo aver ricordato che un’eguaglianza rimane tale se moltiplichiamo entrambi i suoi membri per uno stesso numero, moltiplichiamo entrambi i membri per il numero di Avogadro (NA).

NA ·(3H2 + N2) = NA·(2NH3)

Applichiamo la proprietà distributiva

3 NA ·(H2) + 1 NA ·(N2) = 2NA ·(NH3)

ma per la definizione di mole: un numero di Avogadro di molecole di Azoto costituiscono una mole di Azoto, 3 numeri di Avogadro di molecole di Idrogeno costituiscono 3 moli di Idrogeno e 2 numeri di Avogadro di molecole di Ammoniaca costituiscono 2 moli di Ammoniaca.

Se ne deduce quindi che i rapporti numerici precedentemente individuati tra i coefficienti stechiometrici non sono solo rapporti molecolari, ma anche rapporti molari. In altre parole per ogni 3 moli di Idrogeno reagisce 1 mole di Azoto per dare 2 moli di Ammoniaca.

Esempio – calcolo moli che reagiscono (rapporti numerici)

Calcoliamo quante moli di Idrogeno e di Azoto devono reagire per ottenere 0.35 moli di Ammoniaca.

Il rapporto numerico tra Idrogeno e Ammoniaca è  = 3/2. Tale rapporto deve sempre essere soddisfatto per cui, indicato con x il numero di moli di Idrogeno necessarie per produrre 0,35 moli di Ammoniaca, impostiamo la seguente proporzione

= 3/2. Tale rapporto deve sempre essere soddisfatto per cui, indicato con x il numero di moli di Idrogeno necessarie per produrre 0,35 moli di Ammoniaca, impostiamo la seguente proporzione

3 mol : 2 mol = x : 0,35 mol

che risolta ci da x =  = 0,525 mol

= 0,525 mol

Eseguiamo lo stesso calcolo per l’Azoto, osservando che il suo rapporto numerico con l’ammoniaca è  = 1/2. Impostiamo quindi la proporzione

= 1/2. Impostiamo quindi la proporzione

1 mol : 2 mol = x : 0,35 mol

che risolta ci da x =  = 0,175 mol

= 0,175 mol

* * * * * * * *

I rapporti numerici possono essere facilmente trasformati in rapporti ponderali (e viceversa), utilizzando il Peso molare come coefficiente di conversione. Ricordiamo infatti le due formule di conversione

Dunque per trasformare i coefficienti stechiometrici, che rappresentano il numero n di moli che reagiscono, nell’equivalente quantità in peso W, è sufficiente moltiplicarli tutti per il rispettivo Peso molare. Riprendendo in considerazione la reazione di sintesi dell’Ammoniaca, potremo pertanto scrivere

3H2 + N2 ® 2NH3

6g H2 + 28g N2 = 34g NH3

In generale, prima di eseguire calcoli sulle quantità che reagiscono è bene preparare uno schema che visualizzi i rapporti molari ed i rapporti ponderali, nel modo seguente:

- scrivere la reazione bilanciata (numero di moli n)

- Scrivere i pesi molari (PM) sopra ciascuna specie chimica

- Scrivere i pesi (W) che partecipano alla reazione sotto ciascuna specie chimica, calcolandoli come prodotto tra il Peso molare ed il numero di moli n (dove n è il coefficiente stechiometrico della reazione bilanciata)

Peso molare (PM) |

2 g/mol |

|

28 g/mol |

|

17 g/mol |

Numero di moli (n) |

3H2 |

+ |

1N2 |

= |

2NH3 |

Peso totale (W = n ×PM) |

6 g |

+ |

28 g |

= |

34 g |

In questo modo sono subito evidenti sia i rapporti molari che i rapporti ponderali che intercorrono tra qualsiasi coppia di sostanze coinvolte nella reazione.

Troviamo così che

il rapporto ponderale Idrogeno/Azoto è

il rapporto ponderale Idrogeno/Ammoniaca è  ,

,

il rapporto ponderale Azoto/Ammoniaca è  .

.

il rapporto molare Idrogeno/Azoto è

il rapporto molare Idrogeno/Ammoniaca è  ,

,

il rapporto molare Azoto/Ammoniaca è  .

.

Si noti che si tratta di un’applicazione della legge di Proust delle proporzioni definite e costanti e che, se i calcoli sono stati eseguiti correttamente, viene verificato anche il principio di conservazione della massa: infatti la somma delle masse di tutti i reagenti deve essere uguale alla somma delle masse di tutti i prodotti.

Esempio - Calcolo masse che reagiscono (rapporti ponderali)

Calcoliamo quanti grammi di Idrogeno e di Azoto sono necessari per sintetizzare 100 g di Ammoniaca

Impostiamo una proporzione rispettando il rapporto ponderale Idrogeno/Ammoniaca

6 : 34 = x : 100

che, risolto, dà come risultato x = 17,65 g di H2.

Poiché vi sono solo due reagenti ed il loro peso complessivo deve essere pari al peso dei prodotti (100 g), la quantità di Azoto che reagisce sarà 100g –17,647g = 82,353g. Allo stesso risultato si può giungere risolvendo la proporzione impostata sul rapporto ponderale Azoto/Ammoniaca (28/34)

28 : 34 = x : 100

o quella impostata sul rapporto ponderale Idrogeno/Azoto (6/28)

6 : 28 = 17,647 : x

* * * * * * *

Nel caso in cui una reazione avvenga in più stadi, i prodotti di reazione di uno stadio diventano i reagenti dello stadio successivo. Anche in questo caso è sempre possibile individuare il rapporto stechiometrico esistente anche tra specie appartenenti a stadi diversi. Per far ciò è necessario sommare membro a membro le equazioni bilanciate in modo da eliminare le specie chimiche che compaiono in entrambi i membri

Esempio – Rapporto ponderale in reazione a più stadi

4FeS2 + 11O2 → 2Fe2O3 + 8SO2

2SO2 + O2 → 2SO3

SO3 + H2O → H2SO4

Calcoliamo quanti grammi di Pirite (FeS2) e di Ossigeno O2 sono necessari per ottenere 100 g di acido solforico H2SO4.

Moltiplichiamo per 4 entrambi i membri della seconda equazione e sommiamola membro a membro con la prima in modo da semplificare l’SO2 che rappresenta il prodotto della prima reazione necessario alla seconda per reagire.

4FeS2 + 11O2 → 2Fe2O3 + 8SO2 +

8SO2 + 4O2 → 8SO3 =

_______________________________

4FeS2 + 15O2 → 2Fe2O3 + 8SO3

Moltiplichiamo ora per 8 entrambi i membri della terza equazione e sommiamola membro a membro all’equazione appena ottenuta in modo da semplificare l’SO3.

4FeS2 + 15O2 → 2Fe2O3 + 8SO3 +

8SO3 + 8H2O → 8H2SO4 =

_______________________________

4FeS2 + 15O2 8H2O → 2Fe2O3 + 8H2SO4

Il rapporto ponderale Solfuro/Acido solforico è dunque

Sarà quindi necessaria 119,98 : 196,16 = x : 100 x = 61,16 g di pirite

Il rapporto ponderale Ossigeno/Acido solforico è invece

Sarà quindi necessario 479,98 : 784,65 = x : 100 x = 61,17 g di ossigeno

* * * * * * * *

Nel caso in cui i reagenti non siano presenti in proporzioni stechiometriche, uno di essi sarà presente in quantità insufficiente a permettere agli altri di consumarsi completamente nella reazione. Tale reagente è detto reagente limitante, mentre gli altri sono detti reagenti in eccesso. Mentre il reagente limitante, essendo presente in difetto rispetto al corretto rapporto stechiometrico, reagisce completamente, i reagenti in eccesso rimangono in parte inalterati alla fine della reazione. Anche la quantità di prodotti di reazione che si genera dipende dal reagente limitante che condiziona ovviamente tutte le specie chimiche che partecipano alla reazione.

Esempio – Reagente limitante

Calcoliamo quanti grammi di ammoniaca si sintetizzano facendo reagire 15 g di Idrogeno con 35 g di Azoto. Individuiamo il reagente limitante e calcoliamo quanto di esso rimane inalterato alla fine della reazione.

Il corretto rapporto stechiometrico Idrogeno/Azoto è 3/1 che corrisponde ad un rapporto ponderale 6/28. In base a tale rapporto ponderale calcoliamo quanti grammi di Azoto reagirebbero con 15 grammi di Idrogeno

6g : 28g = 15g : x

che risolta fornisce x = 70 g di Azoto, una quantità superiore a quella disponibile (35 g). L’Azoto è quindi il reagente in difetto e quindi limitante la reazione. Le quantità di tutte le altre specie chimiche che partecipano alla reazione devono essere calcolate rispetto all’Azoto.

Calcoliamo quanto Idrogeno reagisce

6g : 28g = x : 35g x = 7,5 g di Idrogeno

Dunque solo metà dell’Idrogeno reagisce.

La quantità di Ammoniaca che si forma può essere calcolata sommando le quantità dei due unici reagenti 35 + 7,5 = 42,5 g di Ammoniaca. Più in generale sarà necessario risolvere la proporzione impostata sul rapporto ponderale Azoto/Ammoniaca = 28/34

28g : 34g = 35g : x

* * * * * * * *

In molti casi le reazioni non si completano ed i prodotti di reazione si formano in misura inferiore a quanto consentirebbero i reagenti presenti. In tal caso è possibile calcolare una resa percentuale della reazione come rapporto tra la quantità di prodotto realmente ottenuta e la quantità di prodotto stechiometrica.

Esempio – Resa di una reazione

Facendo reagire 30 g di Idrogeno e Azoto in eccesso si ottengono 136g di Ammoniaca. Calcoliamo la resa della reazione.

L’Azoto in eccesso garantisce all’Idrogeno la possibilità di reagire completamente. La quantità teorica di Ammoniaca che si può sintetizzare si calcola attraverso una proporzione impostata sul rapporto ponderale Idrogeno/Ammoniaca = 6/34

6g : 34g = 30g : x x = 170 g di Ammoniaca

La resa della reazione è pertanto (136/170)x100 = 80%

Composizione percentuale e formula di un composto

Nota la composizione percentuale di un composto è possibile assegnargli una formula opportuna. Viceversa, nota la sua formula è possibile determinare la percentuale in peso dei diversi elementi che lo compongono.

L’analisi chimica di una sostanza fornisce in genere la composizione, espressa come percentuale di elementi chimici in essa presenti. Utilizzando questi dati analitici è possibile assegnare al composto una formula minima, detta anche formula empirica, formula grezza o formula bruta. Tale formula indica il minimo rapporto di combinazione tra gli elementi. Essa descriverà adeguatamente la sostanza se si tratta di un composto ionico, mentre potrebbe anche non farlo per un composto molecolare. In quest’ultimo caso è possibile assegnare la formula molecolare, solo se si è riusciti a determinare il Peso molecolare del composto stesso.

Esempio - Dalla composizione percentuale alla formula minima

300g di un composto di Sodio, Zolfo e Ossigeno contengono 97,2 g di Sodio e 67,5 g di Zolfo. Determiniamo la formula minima NaxSyOw del composto.

Il numero di moli contenute in 97,2 g di Sodio è

Il numero di moli contenute in 67,5 g di Zolfo è

Il numero di moli contenute nei rimanenti 135,3 g di Ossigeno è

Il rapporto numerico di combinazione tra gli elementi è dunque Na/S/O = 4,23/2,11/8,46. Per ottenere un rapporto espresso in numeri interi dividiamo tutto per il più piccolo numero di moli ottenuto (2,11).

Si ottiene così Na/S/O = 2/1/4. La formula cercata è Na2SO4.

Esempio - Dalla composizione percentuale alla formula molecolare

L’analisi qualitativa e quantitativa di un composto di Peso molecolare pari a 180 u ha fornito i seguenti risultati 40% di Carbonio, 6,6% di Idrogeno e 53,4% di Ossigeno. Determiniamo la formula molecolare CxHyOw.

Prendiamo arbitrariamente in considerazione 100 g di composto i quali saranno ovviamente costituiti da 40 g di C, 6,7 g di H e 53,3 g di O. Calcoliamo il numero di moli presenti

Il rapporto di combinazione è C/H/O = 3,3/6,6/3,3 =1/2/1.

La formula minima risulta essere allora C1H2O1, che corrisponde ad un peso formula è pari a 30 u. Calcoliamo ora il rapporto tra il peso molecolare ed il peso formula, 180/30 = 6. Ciò significa che la formula molecolare può essere ottenuta moltiplicando per 6 tutti gli indici della formula minima: C6H12O6

Esempio - Dalla formula alla composizione percentuale

Calcoliamo che percentuale di Ferro è presente nei composti FeS2 ed Fe2O3.

Il peso molare del solfuro di ferro è

La percentuale di Ferro in esso presente è 55,85/121,05 = 0,46 pari al 46%.

Il peso molare dell’ossido ferrico è

La percentuale di Ferro in esso presente è 111,70/159,70 = 0,70 pari al 70%

Modelli atomici classici

Negli ultimi decenni dell'Ottocento la maggior parte degli scienziati aderiva alla teoria atomica, ma i dati sperimentali che si andavano accumulando suggerivano l’idea che l’atomo non fosse in realtà il costituente ultimo della materia, ma che possedesse una struttura interna costituita di particelle elettricamente cariche. Al fine di descrivere e giustificare in modo adeguato le nuove caratteristiche che si evidenziavano a livello subatomico vennero creati, nei primi anni del ‘900, diversi modelli atomici.

La struttura interna dell’atomo

I primi indizi sull’esistenza di una struttura interna dell’atomo si ebbero con la scoperta dell’elettrone e la constatazione che tale particella poteva essere estratta da qualsiasi tipo di atomo e doveva pertanto essere considerata un costituente comune di tutti gli atomi.

La scoperta dell'elettrone avvenne grazie ad una serie di esperimenti condotti durante gran parte dell'Ottocento sulla conduzione elettrica attraverso i gas rarefatti.

Fin dal 1838 Faraday aveva osservato, effettuando esperienze di scariche elettriche in atmosfera gassosa rarefatta, strani fenomeni, quali striature, spazi oscuri, senza peraltro essere in gradi di interpretarli. Nel 1858 J. Plücker ebbe l'idea, in seguito rivelatasi estremamente proficua, di avvicinare un magnete alla scarica per verificarne gli effetti. Non vide nulla di interessante poiché il vuoto non era sufficientemente spinto. Nel 1869 J.W.Hittorf riuscì ad ottenere dentro i tubi di scarica un vuoto migliore e cominciò a vedere quelli che noi oggi chiamiamo raggi catodici.

L'apparecchiatura utilizzata, ideata da Crookes (tubo di Crookes o tubo di scarica), è costituita da un tubo di vetro alle cui estremità sono saldati due elettrodi metallici collegati con un generatore di corrente continua con una differenza di potenziale di circa 10.000 volts. All'interno l'aria viene sostituita con un gas qualsiasi.

Si collega il tubo con una pompa del vuoto che fa diminuire gradatamente la pressione interna. Finché la pressione è superiore a 0,4 atm tra i due elettrodi si producono normali scariche elettriche, del tutto simili ai fulmini atmosferici.

Al di sotto di tale valore la scintilla scompare per lasciare il posto ad una luminosità diffusa che, a pressioni di circa 10-6 atm, interessa via via tutto il gas. In queste condizioni il vetro di fronte al catodo emette una debole luminescenza (fluorescenza).

Tale fenomeno fu messo in relazione con possibili radiazioni che potevano essere prodotte dal catodo e che Goldstein in seguito chiamò raggi catodici.

Oggi si sa che si tratta di elettroni che vanno dal catodo all'anodo rendendo la parete che colpiscono fluorescente, ma allora non si sapeva se si trattasse di radiazioni luminose o corpuscolari. Si sapeva solo che si propagavano in linea retta dal polo negativo a quello positivo. Infatti un oggetto metallico frapposto sul loro cammino proiettava nettamente la sua ombra.

Nel 1895 finalmente, Perrin, osservando che un elettroscopio copito dalla radiazione catodica si elettrizzava negativamente, dimostrò che i raggi emessi dal catodo erano dotati di carica negativa.

Altri esperimenti condotti sui raggi catodici dimostrarono che doveva trattarsi di particelle (lo stesso Crookes aveva trovato che i raggi catodici erano in grado di mettere in rotazione, colpendola, una minuscola ruota a pale, interposta sul loro cammino).

D’altra parte l’idea che anche l’elettricità potesse avere una struttura particellare non era nuova, essendo già stata avanzata dal fisico tedesco H.L. Helmholtz (1881), il quale aveva suggerito che, se la materia aveva una struttura discontinua, formata cioè da particelle (atomi e molecole), allora era necessario fare la stessa ipotesi anche per l'elettricità.

Solo ipotizzando l’esistenza di atomi di elettricità potevano essere infatti facilmente interpretate le leggi dell'elettrolisi scoperte da Faraday quasi mezzo secolo prima, secondo le quali vi è una proporzionalità rigorosa tra la quantità di materia che viene decomposta dal passaggio di una corrente elettrica e la quantità di corrente elettrica utilizzata.

In pratica si poteva pensare che per decomporre un certo numero di particelle di materia fosse sempre necessario un certo numero di particelle di elettricità.

Esperienza di Thomson A) Un campo magnetico di intensità H devia una particella in movimento ed elettricamente carica con una forza perpendicolare al vettore velocità.  Applicando ad un tubo di Crookes un campo magnetico di intensità H, perpendicolare al moto della radiazione catodica, gli elettroni, aventi carica e e velocità v, sono sottoposti ad una forza F = Hev che li costringe a muoversi, all’interno del campo, lungo una traiettoria circolare di raggio r. Il valore di r può essere calcolato sulla base della posizione assunta dal punto fluorescente sullo schermo di ZnZ, rispetto alla direzione rettilinea. Poiché F = ma e l’accelerazione centripeta vale a = v2/r, possiamo scrivere

B) Applicando ad un tubo di Crookes un campo elettrico di intensità E, gli elettroni di carica e vengono deviati verso il polo positivo con una forza F = Ee. La forza elettrica risulta sempre perpendicolare alle armature del condensatore e quindi gli elettroni assumono una traiettoria parabolica nel tratto di campo elettrico attraversato. |

L’idea che gli elettroni rappresentassero un costituente fondamentale, comune a tutti gli atomi, venne definitivamente avvalorata dalla determinazione da parte di Thomson (1897) del rapporto carica/massa (e/m) dell’elettrone.

Il valore così trovato è infatti uguale per tutti gli elettroni e non cambia se si sostituisce il tipo di materia che forma il catodo emittente e il gas presente nell'apparecchiatura.

Tale valore risultava quasi 2000 volte maggiore del corrispondente valore e/m tra carica e massa dello ione idrogeno, misurato tramite elettrolisi. Se supponiamo che la carica e dell'elettrone sia uguale e contraria a quella dello ione idrogeno (al fine di garantire la neutralità dell'atomo di idrogeno), il rapporto tra i due valori diventa automaticamente un rapporto tra masse. Le particelle che formavano i raggi catodici risultarono così sorprendentemente possedere una massa quasi 2000 volte inferiore a quella del più piccolo atomo conosciuto. Si cominciò dunque a ritenere plausibile l'ipotesi che gli atomi non rappresentassero il gradino ultimo della materia, ma potessero anch'essi essere composti di particelle più piccole.

Nell'articolo pubblicato su "Philosophical Magazine", Thomson afferma: "Così, sotto questo aspetto, nei raggi catodici abbiamo la materia in uno stato nuovo, uno stato in cui la suddivisione è spinta molto più in là che nel normale stato gassoso, uno stato in cui tutta la materia, cioè la materia derivante da fonti diverse come l'Ossigeno, l'Idrogeno etc. è di un unico tipo, essendo essa la sostanza di cui sono costituiti tutti gli elementi chimici." L'atomo perde per la prima volta la sua indivisibilità e l'elettrone diventa momentaneamente la sostanza prima.

Esperimento di Millikan |

|

Nel 1905 Millikan dimostrò che la carica elettrica è sempre un multiplo intero di una quantità elementare pari 1,602 10-19 Coulomb, carica che si dimostrò appartenere sia al protone che all'elettrone . Nota la carica dell'elettrone ed il rapporto e/m fu quindi possibile ricavare il valore assoluto della massa dell'elettrone .

Il fatto che un atomo neutro contenesse al suo interno particelle negative di massa trascurabile rispetto a quella dell’intero atomo, richiedeva naturalmente la presenza di una controparte positiva alla quale associare la maggior parte delle sua massa.

Nel 1886 Goldstein, usando un tubo a raggi catodici con catodo forato, rilevò dietro al catodo, una luminescenza provocata da radiazioni con movimento opposto a quello dei raggi catodici.. Egli dimostrò che si trattava di particelle cariche positivamente (raggi canale). Poiché la massa di tali particelle era diversa a seconda del gas contenuto nel tubo, si ritenne, correttamente,. che gli elettroni che attraversavano il gas, accelerati dalla differenza di potenziale, fossero in grado, urtandoli, di strappare gli elettroni contenuti negli atomi del gas, trasformandoli così in ioni positivi.

I cationi generati, attirati dal catodo, andavano a formare i raggi canale. Si dimostrava dunque che l’atomo ormata da particelle negative di piccola massa (elettroni) che neutralizzavano una porzione positiva più massiccia.

Lo studio dei raggi canale portò in seguito lo stesso Thomson nel 1907 a scoprire l'esistenza degli isotopi. Sottoponendo i raggi canale a condizioni sperimentali simili a quelle a cui aveva sottoposto gli elettroni per determinarne il rapporto e/m, Thomson scoprì che gli ioni di uno stesso elemento non si distribuivano su di un'unica parabola, ma presentavano diverse traiettorie. Thomson interpretò correttamente i risultati dell'esperimento ipotizzando che all'interno di uno stesso elemento fossero presenti gruppi di atomi aventi le stesse caratteristiche chimiche, ma massa diversa. Erano stati scoperti gli isotopi. Lo strumento utilizzato da Thomson è sostanzialmente analogo all'attuale spettrografo di massa che permette oggi di pesare le sostanze chimiche, calcolando inoltre le percentuali relative dei vari isotopi in base all'annerimento relativo della lastra fotografica che vanno a colpire.

L'ipotesi di Prout (1815) secondo la quale gli atomi degli elementi più pesanti erano costituiti da un diverso numero di atomi di Idrogeno (protone), veniva dunque sostanzialmente confermata. In effetti rimanevano però alcune discrepanze apparentemente inspiegabili.

Se prendiamo ad esempio il Carbonio 12, il cui nucleo è composto da 6 protoni e 6 neutroni troviamo che la sua massa complessiva (12 u) è minore della somma delle masse dei suoi nucleoni presi singolarmente. (6.(1,0073 u) + 6.(1,0087 u) = 12,096 u). Tale apparente contraddizione si spiega ammettendo che una parte della massa dei neutroni e dei protoni si sia trasformata in energia di legame, secondo la relazione einsteniana E = mc2, necessaria a tenerli uniti all'interno del nucleo. Tale quantità è chiamata difetto di massa.

Nel 1896 Henri Becquerel scoprì casualmente la radioattività dell'Uranio. Le sue ricerche vennero proseguite dai coniugi Curie e poi da Rutherford, il quale per primo nel 1898 riconosce le radiazioni da lui chiamate (alfa) e (beta), emesse da elementi radioattivi.

Ben presto risulta chiaro che le radiazioni beta sono costituite da elettroni come i raggi catodici, mentre per lungo tempo resta oscura la natura delle radiazioni alfa.

Pochi anni più tardi P. Villard in Francia scoprì che tra le radiazioni emesse da una sostanza radioattiva ve ne sono di un terzo tipo, chiamate (gamma), che si riconoscono simili ai raggi X.

Bisogna aspettare il 1904 perché Rutherford dimostri che la radiazione alfa è costituita da nuclei di Elio. Lo stesso Rutherford, con la collaborazione di Soddy, fu in grado ben presto di dimostrare che durante l'emissione delle radiazioni alfa e beta, l'elemento radioattivo si trasforma, con un ritmo caratteristico, in un elemento di peso e numero atomico diverso (e quindi in un altro elemento chimico).

Decadimento alfa - Quando un nucleo radioattivo (e quindi instabile) emette una radiazione , esso si trasforma, o decade, nell'elemento che lo precede di due posti nella tabella periodica, a causa della perdita di due protoni (e due neutroni).

Decadimento b- (beta-meno) Quando un nucleo radioattivo emette una radiazione -, esso si trasforma, o decade, nell'elemento che lo segue di un posto nella tabella periodica, a causa della trasformazione di un neutrone del suo nucleo in un protone (che rimane nel nucleo), un elettrone e un antineutrino (che si allontanano dal nucleo).

Decadimento b+ (beta-più) Quando un nucleo radioattivo emette una radiazione +, esso si trasforma, o decade, nell'elemento che lo precede di un posto nella tabella periodica, a causa della trasformazione di un protone del suo nucleo in un neutrone (che rimane nel nucleo), un positrone ed un neutrino (che si allontanano dal nucleo).

Cattura elettronica (cattura K). Si produce quando uno degli elettroni presenti nel guscio più vicino al nucleo (livello K) viene catturato da un protone che si trasforma in un neutrone ed un neutrino

I modelli atomici di Thomson e Rutherford

Agli inizi del '900 vi erano dunque sufficienti elementi per formulare un modello atomico coerente. Nel 1904 J.J. Thomson ipotizzò che gli atomi fossero costituiti da una massa carica positivamente, uniformemente distribuita, all'interno della quale erano presenti gli elettroni, carichi negativamente, in numero tale da determinare l'equilibrio delle cariche e quindi la neutralità.

Per cercare di chiarire la reale distribuzione delle cariche positive e negative che costituiscono l’atomo è possibile studiare gli effetti di deflessione (scattering o diffusione) che queste producono su particelle-proiettile dotate di carica. Tale tecnica, oggi divenuta molto comune per sondare la struttura della materia, fu utilizzata per la prima volta proprio sull’atomo, utilizzando come proiettili particelle a e b.

Nel 1911 Rutherford, a conclusione di una serie di esperimenti di scattering condotti sugli atomi, giunse a modificare profondamente il modello di Thomson

In tali esperimenti vennero fatte collidere particelle a con sottilissimi fogli metallici di oro o platino.

Il loro comportamento risultò sorprendente ed incompatibile con il modello di Thomson: la maggior parte delle particelle attraversava indisturbata il diaframma metallico proseguendo in linea retta, ma alcune particelle subivano vistose deflessioni, in alcuni casi rimbalzando addirittura indietro. Il numero delle particelle deviate risultava correlato al numero atomico degli atomi bombardati.

L’esperienza suggerisce che:

- La struttura atomica sia estremamente rarefatta, visto l’alto numero di particelle in grado di attraversarla

- la diffusione sia provocata dalla repulsione tra particelle alfa incidenti ed una carica positiva estremamente concentrata il cui valore cresca al crescere del numero atomico.

Infatti se la carica positiva fosse diffusa, distribuita uniformemente su tutto il volume atomico, le particelle a sarebbero sottoposte sempre ad una forza risultante nulla o quasi nulla, sia passando all’interno di un atomo, sia passando tra gli atomi (è quel che accade utilizzando come proiettili-sonda gli elettroni, i quali attraversano la materia subendo deviazioni molto piccole, a causa della distribuzione più omogenea e diffusa delle cariche negative dell’atomo).

Per giustificare i risultati dei suoi esperimenti, Rutherford propose dunque un nuovo modello atomico, detto modello planetario con gli elettroni che andavano a costituire una specie di corteccia esterna al massiccio nucleo positivo, in modo da garantire la neutralità a livello macroscopico. Per non cadere nel nucleo, attirati dalla carica positiva in esso presente, gli elettroni negativi dovevano naturalmente possedere un'energia cinetica agente in senso opposto.

Da calcoli effettuati sulle percentuali e sugli angoli di deviazione, Rutherford giunse a calcolare che, mentre l'atomo doveva possedere un diametro dell'ordine di 10-8 cm, il nucleo avrebbe dovuto presentare un diametro dell'ordine di 10-12 -10-13 cm.

Lo stesso Rutherford proporrà in seguito di chiamare protone il nucleo dell’elemento più leggero, l’idrogeno. L'esistenza dei protoni venne definitivamente confermata nel 1925 da Blackett, il quale riuscì ad ottenere immagini fotografiche (camera di Wilson) della trasmutazione dell'azoto,

che, colpito da una particella si trasforma in un nucleo di ossigeno e libera un protone del suo nucleo.

Solo molto più tardi (1932) James Chadwick, bombardando il Berillio con particelle a, scoprì che nei nuclei sono presenti anche particelle neutre, aventi una massa dello stesso ordine di grandezza del protone, anche se leggermente superiore, che vennero chiamati neutroni .

La scoperta dei neutroni permise di giustificare completamente l'esistenza degli isotopi, scoperti in precedenza da Thomson. Inoltre permise di classificare gli atomi dei vari elementi in funzione del numero dei protoni presenti nel loro nucleo.

Il modello di Rutherford presentava tuttavia gravi difetti in quanto gli elettroni che ruotano intorno al nucleo dovrebbero perdere energia cinetica sotto forma di emissione di radiazione elettromagnetica, come previsto dalle leggi dell’elettrodinamica, finendo per cadere sul nucleo. Inoltre gli atomi, in opportune condizioni, sono in grado di emettere e assorbire radiazione elettromagnetica secondo modalità che il modello planetario di Rutherford non era in grado di giustificare.

Fu pertanto necessario introdurre un nuovo modello atomico. Ma prima di parlarne è necessario affrontare, sia pur brevemente, il problema della natura della radiazione elettromagnetica e dei fenomeni di interazione che essa manifesta con la materia.

Bombardando il Berillio con particelle alfa esso emetteva una radiazione invisibile, che non veniva in alcun modo deflessa da campi magnetici o elettrici, il cui unico effetto era di provocare l'emissione da parte di un bersaglio di paraffina, contro cui era diretta, di protoni. Applicando semplicemente il principio di conservazione dell'energia e della quantità di moto e supponendo elastici gli urti tra le particelle, Chadwick fu in grado di calcolare la massa dei neutroni

La radiazione elettromagnetica

Oggi noi consideriamo la luce visibile un tipo particolare di radiazione elettromagnetica, ma i fisici hanno dibattuto per lungo tempo sulla questione.

Modello ondulatorio e corpuscolare a confronto

La disputa intorno alla natura della luce nasce in pratica nel '600 e tra i protagonisti troviamo il grande Newton ed il fisico olandese suo contemporaneo, C. Huygens (1629-1695).

Newton, sostenitore della teoria atomica, riteneva che anche la luce fosse formata da particelle propagantesi in tutte le direzioni in linea retta, soggette alle leggi della meccanica che, come egli stesso aveva scoperto, governavano tutti i corpi materiali.

Huygens riteneva invece (Traitè de la lumiere, 1690) che la luce fosse un fenomeno ondulatorio, simile alle onde sonore che fanno vibrare l'aria o alle onde di energia meccanica che increspano la superficie dell'acqua.

Attraverso il suo modello ondulatorio Huygens riuscì a spiegare i fenomeni di riflessione e quelli di rifrazione, supponendo correttamente che la velocità della luce diminuisse passando da un mezzo meno denso ad uno più denso (ad esempio aria/acqua). Ritenendo che anche la luce, come il suono, fosse una vibrazione meccanica, Huygens ammise l'esistenza di un ipotetico mezzo elastico che chiamò etere, onnipresente nello spazio, al fine di giustificare la propagazione della luce nel vuoto e attraverso i mezzi trasparenti (come l'acqua ed il vetro), dove l'aria non era presente.

Anche Newton poté, d'altra parte, spiegare la maggior parte dei fenomeni luminosi allora noti attraverso il suo modello corpuscolare. La spiegazione della rifrazione in termine di particelle in moto permise ad esempio di ottenere la legge di Snell, ma costringeva Newton ad ipotizzare che le particelle, maggiormente attirate dal mezzo più denso, viaggiassero in questo più velocemente.

Entrambi i modelli erano in grado di giustificare, in prima approssimazione, il comportamento dei raggi luminosi, ma Newton aveva ragione nel contestare ad Huygens il fatto che, se la luce fosse stata un fenomeno ondulatorio, avrebbe dovuto aggirare gli ostacoli, come faceva il suono.

Ciò che caratterizza inequivocabilmente qualsiasi evento ondulatorio sono infatti i fenomeni di rifrazione, diffrazione e di interferenza.

La rifrazione è il fenomeno per cui un’onda subisce una deviazione rispetto alla sua direzione iniziale quando attraversa la superficie di separazione tra due sostanze in cui viaggia a velocità diversa.

La diffrazione è il fenomeno per cui un'onda devia quando incontra un'apertura o un ostacolo avente dimensioni dello stesso ordine di grandezza della lunghezza d'onda (esempi di diffrazione sono i raggi luminosi che si formano quando filtriamo una sorgente luminosa tra le ciglia socchiuse o quando riusciamo ad udire egualmente un suono da una porta aperta anche senza vedere la sorgente sonora).

L'interferenza è quel fenomeno per il quale due onde incontrandosi si intensificano o si indeboliscono a seconda che si sovrappongano cresta con cresta o cresta con cavo, sommando algebricamente la loro ampiezza (un esempio di interferenza si ha quando due onde d'acqua di pari grandezza si scontrano da direzioni opposte e per un breve attimo 'scompaiono’ in corrispondenza alla sovrapposizione del cavo dell'una con la cresta dell'altra).

In realtà la risposta all'obiezione newtoniana era già presente al tempo di Huygens in un'opera di un monaco italiano, F.G. Grimaldi, pubblicata postuma nel 1665. Grimaldi era infatti riuscito a scorgere per la prima volta le frange di interferenza .

Impiegando una sorgente luminosa puntiforme e osservando attentamente su di uno schermo l'ombra di un bastone, constatò che la linea di separazione fra ombra e luce non era netta, ma presentava un certo numero di linee parallele, alternativamente chiare e scure.

Ma il lavoro di Grimaldi non ebbe alcun effetto sulla disputa ed il problema rimase praticamente in sospeso, finché, nella prima metà dell'800, non vennero raccolte prove schiaccianti a favore del modello ondulatorio di Huygens.

Le onde elettromagnetiche

Nel 1801 Thomas Young (1773-1829) compì in Inghilterra un esperimento rimasto famoso.

Egli costruì una sorgente luminosa puntiforme facendo passare la luce di una candela attraverso un minuscolo foro praticato su di un foglio di stagno. Al di là di questo primo foglio ne pose un secondo con due piccoli fori, dietro ai quali mise un schermo. Ora se la luce si propagasse rigorosamente in linea retta si otterrebbero sullo schermo due punti luminosi, lungo le rette congiungenti il primo foro con gli altri due. In realtà grazie al fenomeno di diffrazione i due pennelli di luce si allargano e formano due macchie di luce circolari che si sovrappongono sullo schermo. Osservando questa regione di sovrapposizione Young si accorse che essa era solcata da linee sottili chiare e scure che chiamò frange di interferenza.

Esperienza di Young I raggi diffratti dalle due fenditure partono in fase. Dovendo percorrere un cammino diverso (r1 ≠ r2) possono raggiungere lo schermo in fase (punto B) o fuori fase (punto A) formando una caratteristica alternanza di zone illuminate e scure, dette frange di interferenza. |

Le esperienze di Young vennero riprese da A. Fresnel (1788-1827), il quale riuscì a dimostrare che la teoria ondulatoria permetteva di spiegare tutti i particolari delle frange di diffrazione e di interferenza.

Fresnel portò un altro importante contributo alla teoria ondulatoria della luce. Riprendendo un suggerimento di Young, egli dimostrò che tutte le caratteristiche della luce polarizzata e dell'ottica cristallina trovavano una spiegazione se si supponeva che la vibrazione luminosa nell'onda fosse trasversale, cioè perpendicolare alla direzione di propagazione, mentre la vibrazione sonora nell'aria è longitudinale, cioè parallela alla direzione di propagazione del suono.

Questa conclusione di Fresnel incontrò molte resistenze tra i suoi contemporanei, perché costringeva a ritenere l'etere dotato di proprietà contraddittorie. Se infatti si ammetteva che le vibrazioni luminose dell'etere fossero di natura meccanica, come quelle sonore, esso avrebbe dovuto essere fine e duttile per penetrare in tutti gli interstizi dei corpi trasparenti (visto che la luce si propaga in essi) e contemporaneamente rigido ed incomprimibile, per essere incapace di trasmettere vibrazioni longitudinali (il suono non si propaga infatti nel vuoto dove dovrebbe essere presente l'etere).

Nel 1865 da James Clerk Maxwell (1831-1879) dimostrò che la vibrazione della luce non era di natura meccanica, ma di natura elettromagnetica, sintetizzando in un lavoro teorico le precedenti osservazioni sperimentali di Oersted e di Faraday sul magnetismo e l'elettricità.

Nel 1820 il fisico danese Hans Christian Oersted aveva scoperta che un magnete ed un filo percorso da corrente elettrica si attirano o si respingono reciprocamente (in relazione al verso della corrente o del magnete))

Nel 1831 Michael Faraday trovò che un magnete in movimento esercita una forza su di una carica elettrica ferma costringendola a muoversi (induzione elettromagnetica).

Evidentemente le cariche elettriche in movimento sono in grado di generare forze magnetiche e, viceversa, i magneti in movimento producono forze elettriche.

Maxwell interpretò tali risultati servendosi del calcolo differenziale, e quindi esclusivamente per via teorica, utilizzando il concetto, introdotto da Faraday di campo di forza

Quando un magnete o una carica elettrica si muovono, ovviamente il campo di forze ad esse associato varia la sua intensità. Maxwell riuscì a dimostrare che un campo elettrico la cui intensità varia con il tempo, produce nello spazio circostante un campo magnetico anch'esso di intensità variabile nel tempo. Il campo magnetico, variando di intensità, induce a sua volta un campo elettrico variabile e così via.

In conclusione la perturbazione iniziale del campo non rimane confinata nel punto iniziale, ma si propaga nello spazio come campi di forze elettriche e magnetiche concatenati la cui intensità varia nel tempo con andamento ondulatorio: un'onda elettromagnetica oscillante nello spazio e nel tempo.

La teoria di Maxwell permette anche di ottenere, sempre per via teorica la velocità di propagazione dell'onda elettromagnetica attraverso la relazione:

Dove eo è la costante dielettrica del vuoto e mo la permeabilità magnetica del vuoto. Il valore ottenuto da tale relazione è di 300.000 km/s.

La straordinaria coincidenza tra la velocità delle onde elettromagnetiche e quella della luce (calcolata dall'astronomo danese Ole Christensen Romer nel 1675) suggerì a Maxwell l'ipotesi, in seguito verificata da Hertz, che la luce non fosse altro che una radiazione elettromagnetica di particolare lunghezza d'onda.

Il formalismo matematico della teoria di Maxwell implicava inoltre che l'onda elettromagnetica fosse prodotta da campi elettrici e magnetici aventi direzione ortogonale tra loro e contemporaneamente perpendicolare alla direzione di propagazione dell'onda stessa: si dimostrava perciò che la luce era un fenomeno ondulatorio costituito da onde trasversali.

Nel 1888 Heinrich Hertz fornì una straordinaria conferma alla teoria elettromagnetica di Maxwell, producendo per la prima volta delle onde elettromagnetiche di elevata lunghezza d'onda, scoperta che dette l'avvio allo sviluppo della radiofonia.

Egli non poté vedere lo sviluppo della radiofonia, ma le sue scoperte gli permisero di affermare che "Se qualcosa è stabilito con certezza in fisica, questo è la natura ondulatoria della luce"

Ironia del destino volle che l'anno prima Hertz avesse scoperto l'effetto fotoelettrico, un fenomeno inspiegabile tramite la teoria elettromagnetica classica e che pose le premesse per il suo superamento.

La teoria ondulatoria doveva tuttavia conoscere ancora un grande trionfo con la spiegazione nel 1912 della natura elettromagnetica dei raggi X.

Nel 1895 W.K. Roentgen, aveva osservato che, ponendo di fronte al catodo di un tubo di Crookes un ostacolo di natura metallica, detto anticatodo, quest’ultimo si trasformava in una sorgente di radiazioni estremamente penetranti, che non venivano deviate né da un campo elettrico né da un campo magnetico ed erano in grado di impressionare lastre fotografiche. Esse presero il nome di raggi X o raggi Roentgen.

L'impossibilità di deviarli mediante campi elettrici e magnetici ed il fatto che si propagassero nello spazio con la velocità della luce avevano indotto i fisici a pensare che si trattasse di radiazione elettromagnetica. Ma tutti gli sforzi fatti per rifrangerli, diffrangerli e produrre frange di interferenza rimasero senza risultati fino al 1912.

In quell'anno Max von Laue ebbe l'idea di utilizzare come reticolo di diffrazione un cristallo. Gli atomi e le molecole che formavano il reticolo cristallino risultarono essere sufficientemente vicini da formare fenditure dello stesso ordine di grandezza della lunghezza d'onda della radiazione X.

L’esperimento di von Laue ebbe una doppia valenza:

- stabilì la natura ondulatoria dei raggi Roentgen

- costituì una ulteriore conferma della natura particellare della materia e delle dimensioni atomiche.

Inoltre la tecnica messa a punto, oggi nota come diffrattometria a raggi X, diventò un potente strumento per indagare la struttura della materia. Dalle figure di interferenza prodotte dai raggi X nell’attraversare la materia si può infatti risalire alle posizioni relative degli atomi al suo interno (cristallografia, strutture molecolari complesse: proteine ed acidi nucleici).

I parametri di un’onda e lo spettro elettromagnetico

Essendo dunque la luce un fenomeno ondulatorio, cioè un fenomeno che si riproduce identico a se stesso un gran numero di volte, se ne possono definire alcuni parametri caratteristici.

Si definisce lunghezza d'onda (l) la distanza, misurata in cm, che separa due creste successive.

Si definisce periodo (T) il tempo, misurato in s, che intercorre tra due creste successive.

Naturalmente il rapporto tra lo spazio percorso (l) ed il tempo (T) necessario a percorrerlo ci fornisce la velocità (c) della radiazione elettromagnetica.

Poiché c = 300.000 km/s è una costante se ne deduce che l e T sono direttamente proporzionali.