Probabilità

Probabilità

Questo sito utilizza cookie, anche di terze parti. Se vuoi saperne di più leggi la nostra Cookie Policy. Scorrendo questa pagina o cliccando qualunque suo elemento acconsenti all’uso dei cookie.I testi seguenti sono di proprietà dei rispettivi autori che ringraziamo per l'opportunità che ci danno di far conoscere gratuitamente a studenti , docenti e agli utenti del web i loro testi per sole finalità illustrative didattiche e scientifiche.

Le informazioni di medicina e salute contenute nel sito sono di natura generale ed a scopo puramente divulgativo e per questo motivo non possono sostituire in alcun caso il consiglio di un medico (ovvero un soggetto abilitato legalmente alla professione).

Probabilità

SCHEDE SULLA PROBABILITÀ

Nozione di probabilità

Tutti abbiamo almeno una nozione generica di probabilità: sappiamo che ½ è un valore sensato per una probabilità, mentre 23 o -4 non lo sono. Sappiamo che un evento con una probabilità del 90% è quasi sicuro, mentre uno con una probabilità del 2% è quasi trascurabile.

Si tratta di rendere chiaro il concetto e di preparare il terreno per usarlo nei calcoli.

Il calcolo delle probabilità, nonostante la diffidenza di qualcuno, è utile per più di un motivo.

* Serve a capire che si può indagare con successo anche situazioni incerte, senza dover per forza gettare la spugna affidandosi al caso.

* Serve a imparare che nelle decisioni non conta soltanto quanto è grande la posta in gioco, ma anche quanto è probabile ottenerla.

* Serve a rendersi conto che non tutto è sempre vero o falso, come non tutto è sempre buono o cattivo, bello o brutto e così via.

* Più in generale, serve a sistemare un po’ di concetti filosofici, di quelli che in genere toccano anche (a volte soprattutto) gli adolescenti.

* Serve a imparare nuove tecniche matematiche e quindi di ragionamento.

* Serve a capire come funzionano le assicurazioni, soprattutto nel ramo vita.

* Aiuta un po’ a capire come funziona il mercato di borsa.

* Serve a capire parecchia fisica moderna, che fino a prova contraria appartiene alla cultura più alta a cui una persona di discrete capacità intellettuali oggigiorno possa arrivare.

Probabilità soggettiva

Probabilità soggettiva: misura della fiducia che capiti un certo evento.

Naturalmente, questa misura cambia da persona a persona e, a volte, da momento a momento, ma ha il vantaggio di poter essere usata per ogni evento.

Il modo più generale per misurare una simile fiducia impiega naturalmente un metodo soggettivo: anzitutto, si accetta che su ogni evento sia possibile scommettere con qualcuno; poi si stabilisce che il giocatore o lo scommettitore paga una somma s; in cambio, il banco o l’allibratore paga (senza restituire s) una vincita V se l’evento capita e niente se l’evento non capita.

Lo scommettitore quindi affronta due possibili esiti: o guadagna V-s se l’evento capita o guadagna -s (cioè perde s) se l’evento non capita.

È suggestivo scrivere i guadagni così: si guadagna 100%V-s se l’evento capita, cioè se è certo al 100%, mentre si guadagna 0%V-s se l’evento non capita, cioè se è certo allo 0%.

In una formula: si guadagna pV-s se l’evento capita, cioè se ha una percentuale p di certezza.

Quindi p misura la certezza dell’evento; e perché allora non può misurare anche la fiducia nello stesso evento e assumere valori intermedi fra 100% e 0%, cioè fra 1 e 0?

Naturalmente, un evento, dopo che viene conosciuto, può assumere soltanto le misure di certezza estreme 100% e 0%, ma prima di essere conosciuto nulla impedisce che gli si attribuisca una misura di certezza intermedia.

Resta il fatto che p non è ancora determinato. Per determinarlo, si stabilisce che una scommessa dev’essere equa, cioè né il giocatore né il banco si devono aspettare una perdita; in altri termini: una stessa persona dev’essere disposta a fare sia da giocatore sia da banco.

Ma, dato che il guadagno di uno è la perdita dell’altro, dev’essere sia pV-s ³ 0 sia -(pV-s) ³ 0. Cambiando di segno alla seconda disequazione, si ottiene pV-s £ 0.

Quindi devono valere insieme sia pV-s ³ 0 e pV-s £ 0. Si arriva dunque a pV-s = 0.

Questa può essere interpretata come un’equazione in p, che si risolve subito e dà

.

.

In sostanza: la probabilità soggettiva di un evento è misurata dal rapporto fra quanto si scommetterebbe con equità su quell’evento e quanto si otterrebbe se l’evento capitasse.

Esempio: Alice propone a Bruno questa scommessa: se Bruno, nel giro di 10 anni, le troverà una foglia caduta che risalga da sola sul suo ramo, si riattacchi da sola e riprenda vita, Alice pagherà V, altrimenti niente. Quale somma s sarà disposto a puntare Bruno?

Naturalmente, per quanto le probabilità siano soggettive, l’evento in questione è chiaramente da classificare come impossibile. Pertanto Bruno, se è appena sano di mente, non scommetterà nemmeno un centesimo, perché sarebbe un affare in perdita. La probabilità quindi è p = 0/V = 0.

Esempio: Alice, puntando s, propone a Bruno questa scommessa: se nel prossimo anno scolastico ci sarà almeno un giorno di pioggia sulla scuola, compresi i giorni di festa e gli scioperi, Bruno le pagherà una vincita, altrimenti niente. Quale vincita V sarà disposto ad offrire Bruno?

È decisamente probabile, anzi sostanzialmente certo, che in un intero anno scolastico almeno un giorno pioverà sulla scuola.

Sempre contando sulla sua sanità mentale, Bruno potrà offrire al massimo una vincita uguale alla puntata s, altrimenti la perdita sarebbe quasi sicura. La probabilità quindi è p = s/s = 1.

L’equità della scommessa è un criterio utile anche per rendere un po’ più consistente la misura della probabilità: concretamente, una scommessa è equa se una persona è disposta ad essere indifferentemente il giocatore o il banco. Magari non si riesce a trovare un valore unico, ma almeno si restringe il campo delle probabilità accettabili.

Esempio: Alice e Bruno si accordano per scommettere sul risultato di un referendum; l’evento è: il referendum è valido e i referendari vincono.

Alice stabilisce che, ponendosi come giocatrice e scommettendo s = 5 euro, dovrebbe avere, se capitasse l’evento, V = 12 euro; ponendosi come banco, in cambio dei 5 euro di Bruno sarebbe disposta a dargliene soltanto 9. Naturalmente, la scommessa non viene accettata.

Tuttavia Bruno nota che le probabilità di Alice sono come giocatrice pG = 5/12 = 0,4167 e come banco pB = 5/9 = 0,5556; perciò è chiaro che, secondo Alice, l’evento ha una probabilità di capitare compresa fra 0,4167 e 0,5556.

Bruno si fa l’idea che, secondo Alice, l’evento capiterà con una probabilità di circa (0,4167+0,5556)/2 = 0,4861.

La nozione di probabilità esposta sopra è la più moderna e viene chiamata probabilità soggettiva. È una nozione debole, ma generale. Ci sono altre nozioni, che si possono ottenere come casi particolari di questa; determinano la probabilità con maggior forza, ma non sono sempre applicabili. Ne trattiamo di seguito.

Probabilità frequentistica

Ammettiamo che si voglia conoscere la probabilità di un certo evento, sapendo questa volta che in passato, in N situazioni giudicate simili, l’evento è capitato K volte. Dovrebbe essere intuitivo che la probabilità da usare sia p = K/N, ma si vuole mostrare che questa conclusione discende dalla definizione soggettiva.

È ragionevole stabilire che, scommettendo a favore tutte le N volte, il guadagno totale sarebbe stato KV-Ns.

Se le scommesse, nel loro insieme, devono essere state eque, bisogna che questo guadagno sia stato nullo. Se ne ottiene KV-Ns = 0, da cui si ha K/N = s/V.

Dato poi che s/V è la probabilità che l’evento capiti, la probabilità frequentistica è

.

.

In sostanza: la probabilità frequentistica di un evento è misurata dal rapporto fra le volte che l’evento è capitato e le volte che sono capitate situazioni simili a quella in cui si scommette. (Naturalmente c’è ancora un margine di soggettività nel determinare che cosa sia un evento simile)

Esempio: si vuole sapere qual è la probabilità che, guardando dalla finestra, la macchina più vicina al semaforo rosso sia nera. Si accumula una certa esperienza, ad esempio guardando 100 volte il semaforo diventare rosso e contando quante volte la macchina più vicina è nera. Se la macchina è risultata nera 16 volte, la probabilità frequentistica del nostro evento è 16/100 = 0,16.

Nota per gli accademici: la nozione tradizionale di probabilità frequentistica stabilisce che, per qualunque e, dato l’evento EN = {|K/N-p| < e}, è  . Tale nozione usa già, come predefinita, la nozione di probabilità; senza contare che gli N eventi vanno trattati come equiprobabili. Si tratta quindi di una cattiva definizione; che fra l’altro è ben poco pratica, stante il limite a infinito! Si rimanda per un esame più articolato al convincente Scozzafava R. (1997), Probabilità soggettiva. Significato, valutazione, applicazioni, Masson (Milano), pagg. 43-47.

. Tale nozione usa già, come predefinita, la nozione di probabilità; senza contare che gli N eventi vanno trattati come equiprobabili. Si tratta quindi di una cattiva definizione; che fra l’altro è ben poco pratica, stante il limite a infinito! Si rimanda per un esame più articolato al convincente Scozzafava R. (1997), Probabilità soggettiva. Significato, valutazione, applicazioni, Masson (Milano), pagg. 43-47.

Probabilità classica

Quando si dispone di uno schema casuale con una struttura ben definita, è possibile stabilire in che rapporto stanno tutti i casi in cui un certo evento può capitare e tutti i casi in cui quell’evento capita davvero. La possibilità di trattare con tutti i casi possibili caratterizza la probabilità classica. Esempio: se lancio un dado cubico e mi interessa l’evento per cui esce un 4, so che gli eventi possibili sono le uscite delle 6 facce del dado e gli eventi favorevoli le uscite della faccia con il 4.

È la definizione di probabilità più nota: numero di casi favorevoli diviso il numero di casi possibili. Anche questa si ottiene dalla definizione soggettiva, più o meno come la frequentistica.

Ammettiamo che si voglia conoscere la probabilità di un certo evento, sapendo questa volta che in teoria, su N situazioni giudicate simili, l’evento può capitare K volte. Dovrebbe essere intuitivo che la probabilità da usare sia p = K/N, ma si vuole mostrare che questa conclusione discende dalla definizione soggettiva.

È ragionevole stabilire che, scommettendo a favore tutte le N volte, il guadagno totale sarebbe KV-Ns.

Se le scommesse, nel loro insieme, devono essere eque, bisogna che questo guadagno sia nullo. Se ne ottiene KV-Ns = 0, da cui si ha K/N = s/V.

Dato poi che s/V è la probabilità che l’evento capiti, la probabilità classica è sempre

.

.

In sostanza: la probabilità classica di un evento è misurata dal rapporto fra i casi favorevoli, cioè quelli in cui l’evento capita, e i casi possibili, cioè tutti i casi in cui l’evento può capitare.

Assiomi di Kolmogorov

Tutte le varie interpretazioni della probabilità si dissolvono nei tre assiomi di Kolmogorov. Ma prima non è male spiegare che cosa si intende per assioma.

Un po’ di storia: quando Euclide, intorno al 300 a. C., pubblicò i suoi Elementi, il mondo colto del tempo rimase sbalordito: partendo da cinque nozioni di grande evidenza, riusciva ad ottenere un fiume di risultati matematici, i teoremi. Le nozioni di partenza erano chiamate assiomi o postulati. L’impresa era tale che da allora molti cercarono, e cercano ancora oggi, di fondare le loro teorie sulla base di pochi assiomi, per ottenere tutti gli altri risultati semplicemente ragionando. Oggigiorno in logica il concetto di assioma è slegato dalla necessità di essere evidente: un assioma è soltanto un punto di partenza per una serie di ragionamenti che portano ai teoremi. Tuttavia, quando si fa matematica applicata, l’evidenza resta una caratteristica appetibile. I tre assiomi di Kolmogorov (un grande matematico russo, attivo soprattutto fra le due guerre mondiali) non se la fanno mancare.

Prima di cominciare, serve una nozione fondamentale: le probabilità si usano per misurare la fiducia verso le possibili risposte ad una data domanda. L’insieme di queste possibili risposte, che si indicherà con Â, viene chiamato normalmente spazio campionario, ma non c’è alcun motivo per usare un nome così antipatico; nel seguito, lo si chiamerà appunto l’insieme delle risposte.

Nota: dato che, se una domanda è sensata, è sicuro che almeno una risposta capita, Â può anche rappresentare qualunque evento certo; in effetti, quando un evento è certo, significa che la domanda ha una sola risposta possibile; questa quindi è l’unico elemento di Â.

Inoltre, come  è l’insieme delle risposte possibili, così Æ (l’insieme vuoto, cioè quello che non contiene alcun elemento) può essere interpretato come l’insieme delle risposte impossibili e rappresentare quindi qualunque evento impossibile; in effetti, quando un evento è impossibile, significa che la domanda non ha risposte possibili; queste quindi non sono elemento di alcun insieme.

Qualche esempio.

* Chi vincerà il prossimo derby di Milano?

L’insieme delle risposte  è Milan, Inter, Nessuna squadra.

* Che esito avrà il lancio di questo dado (da 6)?

L’insieme delle risposte  è 1, 2, 3, 4, 5, 6.

* Mi presti l’auto questa sera?

L’insieme delle risposte  è sì, no, forse, altro (tipo: sì, ma...).

* Che tempo farà domani a mezzogiorno sulla nostra scuola?

L’insieme delle risposte  è soleggiato, piovoso, nebbioso, nevoso, nuvoloso e così via.

Si fa notare che tutti gli eventi possono essere rappresentati da risposte ad una data domanda e che tutte le risposte ad una domanda rappresentano eventi.

Assioma sull’intero. È p(Â) = 1.

Con questo assioma si stabilisce che la probabilità di tutte le risposte prese insieme è pari a 1, cioè al 100%. L’affermazione è non soltanto di buon senso, ma anche comoda: se invece di 1 si usasse 3,56, i ragionamenti sulle probabilità risulterebbero molto meno immediati.

Assioma sui valori. Per qualunque evento A, è p(A) ³ 0.

In effetti, è difficile (anche se intellettualmente possibile) dare un senso ad una probabilità negativa.

Per il terzo assioma serve introdurre una nuova nozione (o forse vecchia, se è stata fatta in prima): una partizione di un insieme A è una collezione di insiemi (non vuoti) A1 , A2 , ..., An , che hanno due proprietà: sono disgiunti a due a due, cioè è AiÇAj ¹Æ; la loro unione è l’insieme A, cioè è A1ÈA2È...ÈAn = A.

Questo in termini insiemistici; in termini logici, una partizione di un elenco di giudizi A è una collezione di elenchi (non vuoti) A1 , A2 , ..., An , che hanno due proprietà: sono disgiunti a due a due, cioè è AiÙAj ¹ Æ; la loro unione è l’insieme A, cioè è A1ÚA2Ú...ÚAn = A.

È suggestivo anche notare che la relazione AÙB = Æ si può leggere come l’evento AÙB è un evento impossibile; perciò è impossibile che A e B siano veri insieme; perciò A e B sono incompatibili. Ne segue che la scrittura AÙB ¹ Æ significa invece che A e B sono compatibili.

Esempio: dato l’insieme A dei gatti, non è una partizione A1 : i gatti rossi; A2 : i gatti neri. Infatti, restano fuori tutti gli altri colori, per cui A1ÈA2 non è uguale ad A, ma è soltanto una parte di A.

In termini logici, si ha A: il tal animale è un gatto; A1 : il tal animale è un gatto rosso; A2 : il tal animale è un gatto nero.

Esempio: dato l’insieme A dei gatti, non è una partizione A1 : i gatti con gli occhi chiusi; A2 : i gatti svegli. Infatti, ci sono gatti che sono svegli, ma con gli occhi chiusi, per cui l’intersezione dei due insiemi non è vuota, cioè gli insiemi non sono disgiunti.

In termini logici, si ha A: il tal animale è un gatto; A1 : il tal animale è un gatto con gli occhi chiusi; A2 : il tal animale è un gatto sveglio.

Esempio: dato l’insieme A delle fibre tessili, è una partizione A1 : le fibre vegetali; A2 : le fibre animali; A3 : le fibre artificiali. Infatti, gli insiemi sono disgiunti a due a due e la loro unione è l’insieme delle fibre tessili.

In termini logici, si ha A: la tal fibra è tessile; A1 : la tal fibra tessile è vegetale; A2 : la tal fibra tessile è animale; A3 : la tal fibra tessile è artificiale.

In sostanza, una partizione è semplicemente un metodo razionale di classificare gli elementi di un insieme; le due condizioni per una partizione si interpretano come segue: le categorie di classificazione non devono essere ambigue, cioè non ci dev’essere nessun elemento che potrebbe stare in più di una categoria; tutti gli elementi vanno classificati.

È utile applicare il concetto di partizione sull’insieme delle risposte, perché così le si classifica razionalmente:

* le risposte non devono essere ambigue, cioè ciò che succede deve corrispondere ad una sola risposta;

* le risposte devono essere esaurienti, per cui tutto ciò che succede deve corrispondere a qualche risposta.

Assioma sulla partizione: se {A1 , A2 , ..., An} è una partizione di Â, allora è p(A1)+p(A2)+...+p(An) = 1.

Quindi, confrontando questo assioma e quello sull’intero, se gli eventi individuati nell’insieme delle risposte sono ben classificati, allora la somma delle loro probabilità è uguale alla probabilità dell’intero insieme delle risposte.

Teoremi sugli assiomi di Kolmogorov

Dagli assiomi è possibile ottenere una serie di teoremi che aiutano a capire meglio il concetto di probabilità e che danno alcune utili regole di calcolo.

Teorema (delle probabilità soggettive): per le probabilità soggettive valgono gli assiomi di Kolmogorov.

Dimostrazione.

* Le probabilità soggettive rispettano l’assioma sull’intero, perché, essendo certo che qualche evento di  capiterà, l’unica scommessa equa è quella in cui la somma scommessa è pari alla vincita, cioè in cui è s = V, da cui si ottiene p(Â) = V/V = 1.

* Le probabilità soggettive rispettano l’assioma sui valori, perché V è una somma positiva (se fosse nulla non ci sarebbe scommessa) e s non è negativa (è nulla soltanto quando l’evento è impossibile), perciò è p = s/V ³ 0.

* Le probabilità soggettive rispettano l’assioma sulla partizione, per quanto segue.

Dato che sull’insieme delle risposte è stata fatta una partizione, l’evento che capita è esattamente uno; perciò, mentre tutti hanno scommesso, per un totale di scommesse pari a s1+s2+...+sn , la vincita V è una. Il guadagno totale è quindi V-(s1+s2+...+sn ) e deve valere 0 per l’equità delle scommesse.

La formula per il guadagno totale è dunque V-(s1+s2+...+sn) = 0; da qui si ottiene s1+s2+...+sn = V, cioè (s1+s2+...+sn)/V = 1, cioè s1/V+s2/V+...+sn/V = 1; ma s1/V, s2/V, ..., sn/V sono le singole probabilità delle scommesse sui singoli eventi, perciò si arriva a p(A1)+p(A2)+...p(An) = 1.

CVD

Naturalmente, se gli assiomi valgono per le probabilità soggettive, valgono anche per quelle frequentistiche e classiche, che sono casi particolari delle soggettive.

Teorema (della negazione): per qualunque evento A, è p(ØA) = 1-p(A).

Dimostrazione.

Nell’assioma sulla partizione, limitiamoci a due eventi, per cui è n = 2.

Ne risulta che si può chiamare A1 semplicemente come A e A2 come tutto ciò che non è A, cioè ØA.

Ne risulta anche che è p(A)+p(ØA) = 1.

Basta isolare p(ØA) e si ottiene subito la tesi.

CVD

L’importanza di questo teorema sta nel fatto che dà una regola per calcolare la negazione di un evento: se nego un evento, la sua probabilità si ottiene sottraendo dall’intero la probabilità dell’evento (affermato).

Teorema (dell’evento impossibile): è p(Æ) = 0.

Dimostrazione.

Nel caso in cui A si riduce a Â, è p(Â) = 1, allora, per il teorema della negazione, è p(ØÂ) = 1-p(Â) = 1-1 = 0.

Chiaramente è ØÂ = Æ: se nego un evento certo, ottengo un evento impossibile.

Quindi è anche p(ØÂ) = p(Æ).

Quindi è p(Æ) = 0.

CVD

Con questo teorema, abbiamo fondato con certezza l’intuizione secondo cui un evento impossibile ha probabilità nulla.

Teorema (dell’imperfezione): per qualunque evento A, è p(A) £ 1.

Dimostrazione.

Per il teorema della negazione, è p(ØA) = 1-p(A).

L’evento ØA è un evento qualunque, quindi, per l’assioma sui valori, è p(ØA) ³ 0.

Quindi, confrontando, si arriva a 1-p(A) ³ 0.

Isolando p(A), si ottiene la tesi.

CVD

Con questo teorema abbiamo fondato con certezza l’intuizione secondo cui non esistono eventi con probabilità maggiore dell’evento certo.

Teorema (delle probabilità totali o della disgiunzione incompatibile): se A e B sono incompatibili (cioè se è AÙB = Æ), allora è p(AÚB) = p(A)+p(B).

Dimostrazione.

Nell’assioma sulla partizione, si prendono 3 eventi, per cui è n = 3; A1 si può chiamare semplicemente A, A2 si può chiamare B e A3 indica tutti gli altri eventi, cioè Ø(AÚB).

Dato che lavoriamo su una partizione, per definizione di partizione è è AÙB = Æ, perciò l’ipotesi è rispettata.

Sempre per il fatto che lavoriamo su una partizione, è p(A)+p(B)+p[Ø(AÚB)] = 1.

Di nuovo per il fatto che lavoriamo su una partizione, è p(AÚB)+p[Ø(AÚB)] = 1.

Confrontando le sue ultime uguaglianze e semplificando, si ottiene la tesi.

CVD

L’importanza di questo teorema sta nel fatto che dà una regola per calcolare la disgiunzione di due eventi: se due eventi sono logicamente collegati con la O e sono incompatibili, le loro probabilità si possono sommare.

Teorema (della disgiunzione compatibile): per due eventi qualunque A e B, è p(AÚB) = p(A)+p(B)-p(AÙB).

Dimostrazione.

Si hanno le tre equazioni (si noti che gli eventi dei membri a destra sono partizioni dei rispettivi eventi dei membri a sinistra, per cui la somma delle probabilità è legittima):

p(A) = p(AÙB)+p(A SENZA B);

p(B) = p(BÙA)+p(B SENZA A);

p(AÚB) = p(AÙB)+p(A SENZA B)+p(B SENZA A).

Isolando nelle prime due l’addendo che contiene il connettivo SENZA e sostituendo nella terza, si ottiene p(AÚB) = p(AÙB)+p(A)-p(AÙB)+p(B)-p(BÙA).

Notando che è BÙA = AÙB e semplificando, si ottiene la tesi.

CVD

Con questo teorema, si trova la regola della disgiunzione in tutti i casi, anche quando c’è compatibilità fra gli eventi: se due eventi sono logicamente collegati con la O, allora le loro probabilità si possono sommare, purché si sottragga la probabilità della congiunzione.

Inoltre, il teorema delle probabilità totali è soltanto un caso particolare, che capita quando gli eventi sono incompatibili e quindi è AÙB = Æ.

Usando l’equivalenza trovata in logica secondo cui è A®B = ØAÚB, si può trovare un interessante risultato sulla probabilità dell’implicazione.

Teorema (delle premesse esaurienti): è p(A®B)+p(ØA®B) = 1.

Dimostrazione.

Dalla relazione A®B = ØAÚB, si ottiene subito p(A®B)+p(ØA®B) = p(ØAÚB)+p(AÚB) = p(ØAÚAÚB) =p(ÂÚB) = p(Â) = 1.

CVD

Il teorema mostra che sommare la probabilità di due implicazioni, con due premesse alternative ad un’unica conclusione, dà un risultato certo; ad esempio, è sicuro che se mangio sono vivo o se non mangio sono vivo; infatti, una delle implicazioni è vera.

Le probabilità condizionate

Facciamo una statistica su 20 studenti, distinguendoli secondo i loro gusti per l’aglio e il brodo.

Ci sono 3 persone a cui piace sia l’aglio (A) sia il brodo (B).

Ci sono 7 persone a cui piace l’aglio (A), ma non il brodo (ØB).

Ci sono 6 persone a cui l’aglio non piace (ØA), ma il brodo sì (B).

Ci sono 4 persone a cui non piace né l’aglio (ØA) né il brodo (ØB).

I dati possono essere messi in tabella.

|

A |

ØA |

B |

3 |

6 |

ØB |

7 |

4 |

Poniamoci allora la domanda: qual è la probabilità che a una persona piaccia il brodo, stabilito che le piace l’aglio?

Per rispondere arricchiamo la tabella con qualche totale.

|

A |

ØA |

Tot. |

B |

3 |

6 |

9 |

ØB |

7 |

4 |

11 |

Tot. |

10 |

10 |

20 |

Se si è stabilito che siamo nell’ambito di quelli a cui piace l’aglio, la tabella si riduce a questa.

|

A |

B |

3 |

ØB |

7 |

Tot. |

10 |

Pertanto, usando la definizione frequentistica di probabilità, si ottiene p = 3/10 = 0,3.

Esercizio: nel campione sopra, qual è la probabilità di un’eccezione alla regola se piace il brodo, allora piace l’aglio?

Le eccezioni a questa regola sono tutte le persone a cui piace il brodo, ma non l’aglio. Nella nostra tabella, sono 6.

Il totale esaminato è di 20 persone.

Quindi la probabilità di eccezione nel nostro campione è 6/20 = 0,3.

Poniamo il concetto più in generale e usiamo la seguente tabella.

|

A |

ØA |

Tot. |

B |

fAÙB |

fØAÙB |

fB |

ØB |

fAÙØB |

fØAÙØB |

fØB |

Tot. |

fA |

fØA |

n |

Il simbolo fA rappresenta la frequenza del carattere A, fAÙØB quella del carattere AÙØB e così via; il totale di tutte le frequenze è n.

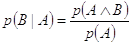

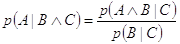

Ci si chiede ora qual è la probabilità di B, stabilito che capita A. Questa probabilità viene scritta come p(B|A) e si legge in vari modi: la probabilità di B, sapendo che è capitato A; la probabilità di B, condizionata da A; la probabilità di B, dato A; la probabilità di B, se è capitato A; e così via.

Ripetendo in astratto il ragionamento precedente, si prende in considerazione soltanto una parte della tabella.

|

A |

B |

fAÙB |

ØB |

fAÙØB |

Tot. |

fA |

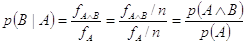

Il risultato è quindi p(B|A) = fAÙB/fA . Questo risultato, tuttavia, non è ancora espresso in termini di probabilità, perciò bisogna tradurre le frequenze in probabilità. Lo scopo è subito raggiunto dividendo le frequenze per il loro totale: sono p(A) = fA/n e p(AÙB) = fAÙB/n.

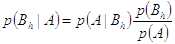

Quindi si ha  . La formula della probabilità condizionata quindi è

. La formula della probabilità condizionata quindi è

.

.

Esempio: qual è la probabilità di ottenere 3 con un dado, sapendo che è uscito un numero dispari?

La probabilità di avere un numero dispari è 3/6. La probabilità di avere 3 e insieme di avere un numero dispari è uguale alla probabilità di avere 3, perciò è 1/6. La probabilità condizionata è allora (1/6)/(3/6) = 1/3.

Teorema (delle probabilità condizionate): per le probabilità condizionate valgono gli assiomi di Kolmogorov.

Dimostrazione.

* Le probabilità condizionate rispettano l’assioma sull’intero, perché è p(Â|A) = p(ÂÙA)/p(A) = p(A)/p(A) = 1.

* Le probabilità condizionate rispettano l’assioma sui valori, perché sono rapporti di probabilità, che non possono essere negative (anzi, il denominatore non può nemmeno essere nullo).

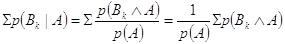

* Le probabilità condizionate rispettano l’assioma sulla partizione, perché è, se k assume tutti i valori interi da 1 a n,

.

.

Per lavorare sull’espressione sopra, si costruisca il seguente schema, che è come quello impiegato per definire le probabilità condizionate, soltanto che l’insieme B è partito in più di due sottoinsiemi e che tutte le frequenze sono state divise per n, in modo da disporre di probabilità frequentistiche.

|

A |

ØA |

Tot. |

B1 |

p(AÙB1) |

p(ØAÙB1) |

p(B1) |

B2 |

p(AÙB2) |

p(ØAÙB2) |

p(B2) |

... |

... |

... |

... |

Bn |

p(AÙBn) |

p(ØAÙBn) |

p(Bn) |

Tot. |

p(A) |

p(ØA) |

1 |

Si nota che la somma delle probabilità p(AÙB1), p(AÙB2), ..., p(AÙBn) dà p(A), perciò si ha Sp(BkÙA)/p(A) = 1.

CVD

La dimostrazione sull’assioma della partizione dà come caso particolare p(B|A)+p(ØB|A) = 1.

Si ha quindi un teorema delle conseguenze esaurienti, da confrontare con il teorema delle premesse esaurienti dimostrato sopra, secondo cui è p(A®B)+p(ØA®B) = 1.

Si può anche trovare qual è la probabilità che valga una certa regola A®B. Infatti, la probabilità che valga la regola sarà uguale alla probabilità che non valgano eccezioni alla regola, cioè che non si abbia AÙØB. In formule, è

p(A®B) = 1-p(AÙØB).

Indipendenza probabilistica

La definizione di probabilità condizionata si può anche scrivere rendendo esplicita p(AÙB) e ottenendo

p(AÙB) = p(A)×p(B|A).

Si ha quindi una regola che indica come trasformare un legame logico fra eventi in un calcolo algebrico sulle probabilità: la probabilità di una disgiunzione è il prodotto di due probabilità.

Il problema è che spesso non è facile determinare direttamente il valore della probabilità condizionata p(B|A), perciò la regola, pur chiarendo i rapporti fra i concetti in discussione, non è molto pratica.

Tuttavia, esistono casi, tutto sommato abbastanza diffusi, in cui la regola prende un aspetto trattabile: quando due eventi sono indipendenti, in particolare quando B è indipendente da A, risulta p(B|A) = p(B); perciò la regola diventa

p(AÙB) = p(A)×p(B).

Si ribadisce che questa regola vale soltanto quando A e B sono indipendenti. Anzi questa regola può anche essere adottata come test per verificare se due eventi sono davvero probabilisticamente indipendenti.

Esempio: si suddivide l’intera regione alpina in zone. Per ogni zona, la probabilità di trovarvi un orso è 0,002; la probabilità di trovarvi una lince è 0,009; la probabilità di trovarvi entrambi è 0,000012. La presenza di orsi e quella linci in una certa zona sono eventi probabilisticamente indipendenti?

Basta moltiplicare le probabilità sui singoli eventi e controllare se il risultato è uguale alla probabilità sulla congiunzione; dato che è 0,002´0,009 = 0,000018 ¹ 0,000012, gli eventi sono dipendenti.

Riassunto dei principali risultati contenuti negli assiomi e nei teoremi

La probabilità è un numero compreso fra 0 e 1, estremi inclusi.

La probabilità di un evento certo è 1, quella di un evento impossibile è 0.

La probabilità della negazione è: p(ØA) = 1-p(A).

La probabilità della disgiunzione è: p(AÚB) = p(A)+p(B)-p(AÙB).

Nel caso particolare in cui A e B sono incompatibili, si ha AÙB = 0, perciò ci si riduce a p(AÚB) = p(A)+p(B).

La probabilità della congiunzione è: p(AÙB) = p(A)×p(B|A).

Nel caso particolare in cui A e B sono indipendenti, si ha B|A = B, perciò ci si riduce a p(AÙB) = p(A)×p(B).

Un’applicazione tratta da Dei delitti e delle pene

Nel capitolo XIV (Indizi, e forme di giudizi) di Dei delitti e delle pene, Beccaria scrive: “Quando le prove di un fatto tutte dipendono egualmente da una sola, il numero delle prove non aumenta né sminuisce la probabilità del fatto, perché tutto il loro valore si risolve nel valore di quella sola da cui dipendono.”

Il calcolo delle probabilità ci permette di dare una forma matematica ben precisa a questi ragionamenti.

Poniamo A: il fatto è basato sulla prova fondamentale; B: il fatto è basato su un’altra prova.

Allora è p(B|A) = 1: è sicuro che, dato che A prova il fatto, allora anche B lo prova.

Da qui, con la definizione di probabilità condizionata, si trova p(AÙB)/p(A) = 1, cioè p(AÙB) = p(A).

Secondo il teorema della disgiunzione compatibile, è p(AÚB) = p(A)+p(B)-p(AÙB), ma usando l’uguaglianza appena trovata si arriva a p(AÚB) = p(B), il cui significato è: la probabilità che il fatto sia basato sul mettere insieme A e B non è diversa dalla probabilità che il fatto sia basato soltanto sulla prova B.

Subito dopo, Beccaria scrive: “Quando le prove sono indipendenti l’una dall’altra, cioè quando gli indizi si provano d’altronde che da se stessi, quanto maggiori prove si adducono, tanto più cresce la probabilità del fatto, perché la fallacia di una prova non influisce sull’altra.”

Il modo di operare è simile al precedente; soltanto, qui non c’è una completa dipendenza, per cui è p(B|A) < 1: anche se A prova il fatto, non è sicuro che B lo provi. Letto in modo più intuitivo: B può non provare il fatto mentre A sì.

In tal caso, procedendo come sopra, ma usando disuguaglianze invece che uguaglianze, si arriva a p(AÚB) > p(B): considerare anche la prova A ha più valore che considerare la prova B da sola.

Si noti che l’indipendenza piena, cioè p(AÙB) = p(A)×p(B), è un caso particolare di p(B|A) < 1, purché sia p(B) < 1; infatti si ha p(AÙB)/p(A) < 1, cioè p(AÙB) < p(A). Quando p(B) vale p(AÙB)/p(A), si ottiene appunto il caso di indipendenza piena.

Subito prima di questi due ragionamenti, Beccaria scrive: “Quando le prove di un fatto sono dipendenti l’una dall’altra, cioè quando gl’indizi non si provano che tra di loro, quanto maggiori prove si adducono tanto è minore la probabilità del fatto, perché i casi che farebbero mancare le prove antecedenti fanno mancare le susseguenti.”

Questo punto è piuttosto strano e verrebbe da giudicarlo un’illusione: non si capisce davvero come aggiungere prove, sia pure inutili, possa diminuire una certezza.

L’unico modo di dare un senso al ragionamento mi sembra notare che, se si deriva la formula p(B|A) = p(AÙB)/p(A) rispetto a p(A) e si suppone p(AÙB) costante rispetto a p(A) (ipotesi decisamente forte e ben poco coerente con la premessa di Beccaria), si ottiene dp(B|A)/dp(A) = - p(AÙB)/ p(A)2 < 0.

In ogni caso, non riesco a pensare ad alcun esempio a sostegno di quest’ultimo ragionamento di Beccaria.

Il teorema di Bayes

Le probabilità condizionate si legano fra loro in modi di notevole interesse. Eccone alcuni.

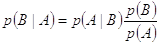

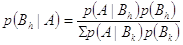

Teorema (di Bayes, per una conseguenza): è  .

.

Dimostrazione.

La definizione di probabilità condizionata dà p(AÙB) = p(A)×p(B|A).

Invertendo A e B, si cambiano soltanto gli aspetti nominali, ma la sostanza non è toccata, perciò si può anche scrivere p(BÙA) = p(B)×p(A|B).

Dato che i membri a sinistra sono uguali, lo sono anche i membri a destra, perciò è p(A)×p(B|A) = p(B)×p(A|B).

Isolando p(B|A), si ottiene la tesi.

CVD

Esempio (dati inventati): il 30% dei dipendenti è in buoni rapporti con il proprio responsabile; il 15% dei dipendenti ottiene un aumento a fine anno; fra quelli che sono in buoni rapporti con il responsabile, uno su 4 ottiene un aumento. Qual è la probabilità che un aumento sia dovuto a buoni rapporti con il proprio responsabile?

Prima di tutto, vanno formulate le varie probabilità, cioè A: c’è un aumento di stipendio a fine anno; R: un dipendente è in buoni rapporti con il proprio responsabile.

È pratico partire sempre dalla domanda, che si formula come p(R|A).

Bisogna ora trovare p(A), p(R) e p(A|R).

Si ottiene p(A) = 15% = 0,15, p(R) = 30% = 0,3 e p(A|R) = 1/4 = 0,25.

Il teorema di Bayes perciò porta a p(R|A) = 0,25´0,3/0,15 = 0,5.

Esempio: qual è la probabilità che esista un creatore di tutto, sapendo che la vita si è sviluppata?

In formule, si ha B: esiste un creatore di tutto; A: la vita si è sviluppata.

Interessa conoscere p(B|A).

Per farlo, bisogna conoscere p(A|B), p(A) e p(B).

Il valore di p(A) si ottiene subito: siamo vivi e circondati da un mondo vivo, perciò è sicuro che la vita si è sviluppata; si ha dunque p(A) = 1.

Il valore di p(A|B) è altrettanto semplice da trovare: se esiste un creatore (se...), allora sicuramente la vita si sviluppa, se no che creatore è? Quindi si ha subito p(A|B) = 1.

Non è invece così immediato trovare un valore per p(B), che quindi manteniamo in forma letterale.

Anche senza conoscere il valore di p(B), si ottiene comunque un risultato significativo: sostituendo i valori trovati nel teorema di Bayes, si ottiene p(B|A) = p(B).

In parole: la probabilità che esista un creatore, sapendo che la vita si è sviluppata, è la stessa che esista un creatore non sapendolo. Sapere che la vita si è sviluppata non aumenta la probabilità che esista un creatore. Naturalmente, ciò è valido anche per alcune altre interpretazioni di A, come il mondo è (abbastanza) ordinato.

Tutto ciò comunque non dovrebbe stupire: notoriamente, l’esistenza di un creatore è oggetto di fede e la fede, per definizione, non è conoscenza; pertanto, elementi di evidenza empirica difficilmente possono influire.

Si lascia come esercizio di interpretare A con altre informazioni sull’esistenza.

Teorema (di Bayes, per più conseguenze): è  .

.

Dimostrazione.

Sostituendo Bh a B nel teorema di Bayes per una conseguenza, si ottiene  Sp(A|Bk)p(Bk) e la tesi è dimostrata.

Sp(A|Bk)p(Bk) e la tesi è dimostrata.

Intanto si può notare che, per definizione di probabilità condizionata, è p(A|Bk) = p(AÙB)/p(Bk). Poi si sostituisce questo risultato nell’ultima equazione scritta, ottenendo, dopo la semplificazione di p(Bk), il risultato p(A) = Sp(AÙBk).

Dimostrando il teorema delle probabilità condizionate, si è già trovato che questa uguaglianza è sempre vera.

Pertanto, a furia di sostituzioni, si arriva alla tesi.

CVD

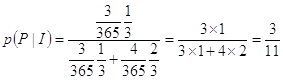

Esempio: sapendo che una linea elettrica ha guasti nel primo terzo della sua lunghezza in 3 giorni all’anno e nei secondi due terzi in 4 giorni all’anno, qual è la probabilità che un’interruzione di corrente sia dovuto ad un guasto nel primo terzo della linea?

Si ponga I: c’è un’interruzione; P: c’è un guasto nel primo terzo; S: c’è un guasto nei secondi due terzi.

Per formulare il problema, conviene partire dalla domanda, che porta a p(P|I).

Il numeratore del teorema di Bayes sarà quindi dato da p(I|P)p(P).

Il denominatore sarà dato da p(I|P)p(P)+p(I|S)p(S).

Sostituendo i valori numerici, si ha per il numeratore (3/365)´(1/3) e per il denominatore (3/365)´(2/3).

Si arriva perciò a  .

.

Il teorema di Bayes per più conseguenze è anche chiamato teorema delle cause, perché gli eventi B1 , B2 , ..., Bn possono essere interpretati come le possibili cause dell’evento A.

Esempio (dati inventati): la metà dei ritardi sui treni è dovuta a disorganizzazione, il 30% a errori dei singoli e il 20% a guasti. La disorganizzazione porta a ritardi in 5 casi su 10, gli errori in 7 casi su 10 e i guasti in 9 casi su 10. Qual è la probabilità che un ritardo sia dovuto a disorganizzazione?

Gli eventi possono essere indicati come R: ritardo di un treno; D: disorganizzazione delle ferrovie; S: errore di un singolo; G: guasto al treno o alla linea.

La domanda si formula come p(D|R).

Il numeratore allora è p(R|D)p(D).

Il denominatore è quindi p(R|D)p(D)+p(R|S)p(S)+p(R|G)p(G).

Ne risulta p(D|R) = 0,5´0,5/(0,5´0,5+0,3´0,7+0,2´0,9) = 0,390625.

La probabilità che sia la disorganizzazione delle ferrovie a determinare un certo ritardo quindi è pari a circa 0,39.

C’è poi un’ulteriore interpretazione del teorema di Bayes per più conseguenze: le probabilità p(B1), p(B2), ..., p(Bn) possono essere interpretate come le probabilità che capitino gli eventi B1 , B2 , ..., Bn valutate prima di conoscere l’evento A (probabilità a priori), mentre le probabilità p(B1|A), p(B2|A), ..., p(Bn|A) si possono interpretare come le probabilità che capitino gli eventi B1 , B2 , ..., Bn valutate dopo che si conosce l’evento A (probabilità a posteriori).

Il passaggio dalle probabilità a priori a quelle a posteriori, chiamato apprendimento bayesiano, è regolato dalle p(A|B1), p(A|B2), ..., p(A|Bn), chiamate verosimiglianze.

Esempio: in un’indagine, l’inquirente si è fatto l’idea che una certa persona abbia una probabilità del 70% di essere innocente (probabilità a priori); è lì lì per passare ad altri sospetti, quando la scientifica gli fa avere il risultato di alcune analisi, secondo le quali il DNA della persona è uguale a quello trovato sotto le unghie della vittima. Facciamo l’ipotesi, per niente realistica, che gli esami sul DNA siano infallibili.

È intuitivo che un innocente non lascia il suo DNA sotto le unghie della vittima, mentre un colpevole può benissimo lasciarlo; per esperienza su casi precedenti, si sa che lascia il DNA nel 20% dei casi.

La domanda naturalmente è: qual è la probabilità che la persona sia colpevole, dopo il rapporto della scientifica (probabilità a posteriori)?

Si ponga C: la persona è colpevole; D: il DNA sotto le unghie della vittima è quello della persona.

La domanda si formula come p(C|D).

Vale la pena di chiarire che le verosimiglianze sono p(D|C) = 20% = 0,2 e p(D|ØC) = 0.

Il numeratore allora è p(D|C)p(C).

Il denominatore è quindi p(D|C)p(C)+p(D|ØC)p(ØC).

Ne risulta p(C|D) = 0,2´,07/(0,2´0,7+0´0,3) = 1.

Come si nota e come è intuitivo, in un caso come questo non ha alcuna importanza il valore di p(D|C), perché comunque, che capiti spesso o no, l’unico a poter lasciare il proprio DNA sotto le unghie della vittima è il colpevole.

In sintesi: mentre l’inquirente, prima di conoscere le verosimiglianze fornite dall’esame del DNA, era convinto al 70% che la persona fosse innocente, dopo l’esame è sicuro che è colpevole.

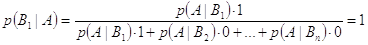

L’apprendimento bayesiano mostra un aspetto particolarmente interessante: se una persona è convinta di sapere qual è l’evento Bh che capita, non c’è alcuna verosimiglianza che possa fargli cambiare idea. Ecco perché: poniamo, senza perdita di generalità, che la persona sia convinta che capiterà l’evento B1 .

In tal caso, si ha p(B1) = 1 e quindi p(B2) = ... = p(Bn) = 0.

Il teorema di Bayes prende allora questo aspetto:  .

.

Tutte le altre probabilità a posteriori dunque valgono 0, come è facile capire anche con un calcolo diretto.

Quindi, anche dopo aver conosciuto l’evento A, la persona resta convinta che sarà l’evento B1 a capitare.

Morale: in assenza di qualunque dubbio, non c’è esperienza concreta che possa far cambiare idea.

Dalle probabilità condizionate alle frequenze

Spesso è più intuitivo leggere, o presentare ad altre persone, una tabella di frequenze, eventualmente relative, invece che alcune probabilità condizionate. Ecco come passare dalle probabilità alle frequenze, basandoci sull’esempio dei dipendenti in buoni rapporti col responsabile che ottengono un aumento. Poniamo che ci vengano fornite soltanto le seguenti probabilità: p(A) = 0,15, p(R) = 0,3 e p(A|R) = 0,25.

Se poniamo pari a 1 il totale dei casi, si ha chiaramente p(ØA) = 0,85 e p(ØR) = 0,7. Inoltre, si ottiene p(AÙR) = p(A|R)p(R) = 0,25´0,3 = 0,075. La tabella quindi è già parzialmente compilata:

|

A |

ØA |

Tot. |

R |

0,075 |

|

0,3 |

ØR |

|

|

0,7 |

Tot. |

0,15 |

0,85 |

1 |

I dati rimanenti si ottengono per differenza, ad esempio p(AÙØR) = p(A)-p(AÙR) = 0,15-0,075 = 0,075. Alla fine si ha:

|

A |

ØA |

Tot. |

R |

0,075 |

0,225 |

0,3 |

ØR |

0,075 |

0,625 |

0,7 |

Tot. |

0,15 |

0,85 |

1 |

Se poi si preferiscono i numeri interi, si può ad esempio moltiplicare per 1.000 (tenendo sempre presente che questo è un totale di comodo e non la numerosità del campione indagato):

|

A |

ØA |

Tot. |

R |

75 |

225 |

300 |

ØR |

75 |

625 |

700 |

Tot. |

150 |

850 |

1000 |

ESERCIZI SULLE PROBABILITÀ

EVENTI ELEMENTARI E OPERATORI LOGICI

1) Calcola la probabilità che da un’urna con 3 palline bianche, 4 nere e 5 rosse esca una pallina nera. [0,3333]

2) Calcola la probabilità che da un’urna con 3 palline bianche, 4 nere e 5 rosse esca una pallina non rossa. [0,58333]

3) Calcola la probabilità che da un’urna con 3 palline bianche, 4 nere e 5 rosse, estraendo in blocco, escano due palline rosse. [0,151515]

4) Calcola la probabilità che da un’urna con 3 palline bianche, 4 nere e 5 rosse, con un’estrazione in blocco di 3 palline, esca una pallina per colore. [0,272727]

5) Calcola la probabilità che da un’urna con 3 palline bianche, 4 nere e 5 rosse, in un’estrazione in blocco di 2 palline, si ottenga una pallina bianca e una nera. [0,181818]

6) Calcola la probabilità che, lanciando un dado con 8 facce, il 5 esca due volte di seguito. [0,015625]

7) Calcola la probabilità che, lanciando due volte un dado di 8 facce, si ottenga prima l’1 e poi il 7. [0,015625]

8) Calcola la probabilità che, lanciando due volte un dado di 20 facce, la somma dei risultati di ciascun lancio sia 5. [0,01]

9) Calcola la probabilità che, lanciando tre volte un dado di 4 facce, la somma dei risultati di ciascun lancio sia 2. [0]

10) Calcola la probabilità che, lanciando tre volte un dado di 4 facce, la somma dei risultati di ciascun lancio sia 5. [0,09375]

11) Calcola la probabilità che, lanciando tre volte un dado di 4 facce, la somma dei risultati sia minore di 5. [0,0625]

12) Calcola la probabilità che, estraendo una carta da un mazzo di francesi (♥♠♦♣), si ottenga un fante. [0,0769]

13) Calcola la probabilità che, estraendo una carta da un mazzo di francesi (♥♠♦♣), si ottenga un fante di quadri. [0,0192]

14) Calcola la probabilità che, estraendo una carta da un mazzo di francesi (♥♠♦♣), si ottenga un re o una carta di fiori. [0,30769]

15) Calcola la probabilità che, estraendo cinque carte in blocco da un mazzo di francesi (♥♠♦♣), si ottengano tutte carte dello stesso seme (colore). [0,00198]

16) Calcola la probabilità che, estraendo cinque carte in blocco da un mazzo di francesi (♥♠♦♣) limitate ai valori 7, 8, 9, 10, J, Q, K, A, si ottengano tutte carte dello stesso seme (colore). [0,001112]

17) Calcola la probabilità che, alla roulette (18 numeri rossi, 18 numeri neri e lo 0 verde), esca due volte di fila un numero rosso. [0,236669]

18) Calcola la probabilità che, alla roulette (18 numeri rossi, 18 numeri neri e lo 0 verde), esca cinque volte di fila un numero rosso. [0,027249]

19) Calcola la probabilità che, alla roulette (18 numeri rossi, 18 numeri neri e lo 0 verde), esca tre volte di fila lo 0. [0,00001974]

20) Calcola la probabilità che, alla roulette (18 numeri rossi, 18 numeri neri e lo 0 verde), escano quattro numeri, rossi o neri, ma con colori alternati. [0,112025]

21) Calcola la probabilità che, giocando a tombola, fra i primi 4 estratti ci sia il 19. [0,0452]

22) Si sa che su 150.000 auto di un certo modello se ne sono vendute 30.000 rosse, 45.000 nere e 60.000 bianche. Qual è la probabilità che una qualunque delle auto vendute sia nera? Quante auto rosse ci si aspetta di vendere l’anno prossimo, sapendo che ci si aspetta un volume di vendite totale di 225.000 auto? [0,3; 45.000]

23) Un lotto di 100 macchinari ha avuto questo ciclo di vita: dopo i primi 2 anni, ne sono stati dismessi 15; dopo altri 2 anni, altri 28; dopo altri due anni, altri 31; dopo altri 2 anni, tutti i macchinari sono stati dismessi. Qual è la probabilità che un macchinario di questo genere duri più di 4 anni? E che duri dai 4 ai 6 anni? [0,57; 0,59]

24) Amanda è disposta a scommettere 5 euro che fra una settimana sullo Schiaparelli cada almeno una goccia di pioggia. Se vince, ottiene 100 euro. Qual è la probabilità di vittoria secondo Amanda? [0,05]

25) A Elviro viene proposto di puntare 10 euro sul fatto che Zi’ P’nuzzu riesca ad essere assunto nel giro di due mesi come giornalista; se Elviro vince, riceve 300 euro. Qual è la probabilità dell’evento implicita nella scommessa? [0,03333]

26) Dimostra che, se è p(A) = 0, allora è p(AÚB) = p(B).

27) Dimostra che, se sono p(A) = p(B) = 1, allora è p(AÙB) = 1.

DEFINIZIONE DI PROBABILITÀ CONDIZIONATA

28) Sappiamo che sono p(AÙB) = 1/6, p(A) = 1/3 e p(B) = 1/3. A e B sono indipendenti? [No]

29) In un test d’ammissione, il 4% sbaglia chimica, il 3% sbaglia storia, l’1% sbaglia tutt’e due. Gli eventi sono indipendenti? Fra quelli che hanno sbagliato chimica, che percentuale ha sbagliato anche storia? [No; 1/4]

30) Qual è la probabilità che la somma dei risultati di due dadi sia 10, se un dado ha dato 5? [1/6]

31) Qual è la probabilità di estrarre un 7 da un mazzo di 40, sapendo che è stata estratta una carta maggiore di 5? [1/5]

32) Nella popolazione indicata in tabella, qual è la probabilità di un’eccezione alla regola secondo cui tutti quelli che corrono indossano un cappellino?

|

Quanti hanno un cappellino |

Quanti non hanno un cappellino |

Quanti corrono |

12 |

15 |

Quanti non corrono |

34 |

25 |

[15/86]

33) La probabilità che in un certo periodo dell’anno piova e ci sia vento è 0,06; la probabilità che ci sia vento è 0,15; qual è la probabilità che piova? [Se gli eventi sono indipendenti, 2/5]

34) Data la tabella che segue, qual è la probabilità che il farmaco aiuti la guarigione?

|

Guariti |

Non guariti |

Curati dal farmaco |

45 |

30 |

Non curati dal farmaco |

5 |

20 |

[3/5]

35) Dimostra che è p(A|B) = 0 sempre e soltanto se è p(B|A) = 0.

36) Dimostra che, se A e B sono incompatibili e se sono p(A) > 0 e p(B) > 0, allora A e B sono dipendenti.

37) Dimostra che è  .

.

38) Calcola e confronta i valori di p(A|A) e p(A®A).

39) Calcola e confronta i valori di p(ØA|A) e p(A®ØA).

40) Siano dati i seguenti eventi: A: esce un 5 su un dado cubico, B: esce un numero pari su un dado cubico, C: esce un fante in un mazzo francese, D: esce una carta di picche in un mazzo francese. Calcola le seguenti probabilità.

a) p(A|B). [0]

b) p(B|A). [0]

c) p(A|ØB). [0,33333]

d) p(CÙD). [0,01923]

e) p(C|BÙD). [0,07692]

f) p(AÚB|CÚD). [0,66667]

g) p(CÚØD). [0,76923]

h) p(ØAÙØB). [0,33333]

i) p(A|CÙØD). [0,16667]

TEOREMA DI BAYES PER UNA CONSEGUENZA

41) Se in un mese la probabilità che un cellulare si guasti è 0,003, che cada è una su 50 e lo 0,7% dei cellulari che cadono si guasta, qual è la probabilità che un cellulare sia caduto, sapendo che è guasto? [0,04667]

42) A Bridgeborough, un uomo su 3 è scozzese. Il 30% degli scozzesi indossa il kilt. Se la probabilità che un abitante indossi il kilt è 0,1, qual è la probabilità che un uomo col kilt sia scozzese? [1]

43) Al conservatorio di Portofino, c’è una probabilità pari a 0,4 che uno studente sia femmina. Uno studente su 4 studia il violino. Le femmine sono la metà dei violinisti. Qual è la probabilità che una femmina studi il violino? [0,3125]

44) Su 10 gatti che graffiano, 8 agitano la coda. La probabilità che un gatto agiti la coda è 0,35; la probabilità che graffi è 0,4. Qual è la probabilità che un gatto che agita la coda graffi? [0,914286]

45) Il 90% dei dischi con buona musica ha una bella copertina. Tre dischi su 10 hanno una bella copertina e uno su 20 ha buona musica. Qual è la probabilità che un disco con la copertina bella abbia buona musica? [0,15]

46) In un ufficio, un documento su 6 è segreto e 4 su 9 sono chiusi a chiave in un cassetto. I documenti segreti sono sempre chiusi a chiave. Qual è la probabilità che i cassetti chiusi a chiave contengano documenti segreti? [0,375]

47) La probabilità che ci siano nuvole è 0,35; la probabilità che piova è 0,1. La probabilità che quando piove ci siano nuvole è 0,97. Qual è la probabilità che quando ci sono nuvole piova? [0,277143]

48) La probabilità che io beva caffè la sera è 0,1. La probabilità che non dorma è 0,07. Se prendo un caffè, non dormo il 70% delle volte. Qual è la probabilità che io non dorma, avendo preso un caffè? [1]

49) Il 30% di chi guarda i puffi alla tele è miope; un quarto della gente guarda i puffi; un terzo della gente è miope. Qual è la probabilità che un miope guardi i puffi? [0,225]

50) La probabilità che una moneta sia falsa è lo 0,2%; il 68% delle monete false ha difetti; il 5% delle monete ha difetti. Qual è la probabilità che una moneta difettosa sia falsa? [0,0272]

51) Il 6% dei truffatori ha una fossetta sul mento. I truffatori sono il 2% della popolazione, quelli con la fossetta sul mento sono il 5%. Se uno ha la fossetta, qual è la probabilità che sia un truffatore? [0,024]

51a) Il 5% degli impiegati di un ufficio consegna in ritardo la maggioranza delle pratiche; 1 impiegato su 13 ha problemi di salute. Fra gli impiegati con problemi di salute, il 16,25% consegna la maggioranza delle pratiche in ritardo. Qual è la probabilità che un impiegato che consegna la maggioranza delle pratiche in ritardo abbia problemi di salute? [0,105625]

51b) Il 12% dei venditori di auto usate è disonesto; 2 venditori su 5 hanno la sede nei capoluoghi di provincia; il 36% dei venditori disonesti ha sede in un capoluogo di provincia; qual è la probabilità che un venditore con sede nel capoluogo di provincia sia disonesto? [0,108]

51c) Una certa ditta di revisione, dopo aver studiato molte imprese, ha stabilito che il 45% di esse supera un certo insieme di indici di indebitamento. Nello stesso campione, le imprese fallite sono state il 9%. Inoltre, il 95% delle imprese fallite superava gli indici di indebitamento. Qual è la probabilità che un’impresa fallisca, dato che supera gli indici di indebitamento? [0,19]

51d) In serie A, un giocatore su 20 ha vinto un campionato e 6 giocatori su 10 non hanno infortuni nell’anno. Il 63% di quelli che hanno vinto il campionato non ha subito infortuni nell’anno. Qual è la probabilità di vincere il campionato, se non si subiscono infortuni? [0,0525]

51e) Secondo le statistiche di un ufficio vendite, incrocia le braccia il 51% delle persone che rifiutano di acquistare un dato prodotto. In assoluto, il 42% delle persone ha incrociato le braccia, mentre il prodotto è stato venduto nel 18% delle visite. Qual è la probabilità di non vendere il prodotto, se la persona incrocia le braccia? [0,9957]

TEOREMA DI BAYES PER PIÙ CONSEGUENZE

52) In un certo giorno, la probabilità che le candele siano sporche è dello 0,1%, che la batteria sia esaurita è dello 0,2%; le candele sporche impediscono ad un’auto di partire con una probabilità dello 0,6%; la batteria esaurita impedisce la partenza con una probabilità del 100%; altri eventi impediscono la partenza con una probabilità del 5%. Qual è la probabilità che l’auto non parta a causa delle candele sporche? [0,002547]

53) Una pubblicità è stimata raggiungere il 30% del pubblico. Un’indagine mostra che il 6% di chi non conosce la pubblicità e il 15% di chi la conosce ha comprato l’articolo. Qual è la probabilità che chi ha comprato l’articolo conosca la pubblicità? [0,517241]

54) Una persona su tre disturba un’ape quando è nelle sue vicinanze. Un’ape disturbata punge in 7 casi su 100; una non disturbata in 2 casi su 100; qual è la probabilità che una persona punta da un’ape prima l’abbia disturbata? [0,636364]

55) Data la tabella che segue, quanto vale P(B|Pallina rossa?)

Urna |

Palline rosse |

Palline bianche |

Palline azzurre |

A |

3 |

4 |

1 |

B |

1 |

2 |

3 |

C |

4 |

3 |

2 |

[0,125]

56) Un test ha 5 possibili risposte. Chi non ha studiato risponde a caso. Chi ha studiato risponde giusto. Di solito, gli studenti che studiano sono la metà. Qual è la probabilità che uno studente abbia studiato, dato che ha risposto giusto? [0,833333]

57) In un telefilm ci sono 3 attori. La trama è fatta in modo che in scena ci sia sempre uno di loro, ma che non si incontrino mai. Aldo appare per il 50% del tempo, Brigitta per il 35% e Clelia per il 15%. Il 70% di quelli a cui piace Aldo guarda la trasmissione; per Brigitta la percentuale è il 75% e per Clelia è il 95%. Qual è la probabilità che Clelia piaccia a chi guarda la trasmissione? [0,463576]

58) Errore e malafede sono equidistribuiti. La probabilità che la malafede porti a un falso in bilancio è 0,9; la probabilità che un errore porti a un falso in bilancio è 1. Qual è la probabilità che un falso in bilancio sia dovuto a malafede? [0,473684]

59) In Italia, una persona su 100.000 è un terrorista, 1 su 4 è sbadata e il restante (i “solidi”) non sono nessuno dei due. La probabilità che un terrorista abbandoni una borsa in stazione è 0,2; che la abbandoni uno sbadato è 0,05; che la abbandoni un solido è 0,001. Qual è la probabilità che una borsa sia stata abbandonata da un terrorista? [0,000151]

60) Il 45% delle nuvole da ovest portano pioggia; lo stesso vale per il 30% delle nuvole da sud, per il 20% da est e per il 35% da nord. Di tutte le nuvole, il 60% viene da ovest, il 20% da sud, il 15% da est e il 5% da nord. Qual è la probabilità che una pioggia sia causata da nuvole che vengono da ovest? [0,715232]

61) Un cavallo si spaventa nello 0,7% del tempo, corre nel 5,3% ed è tranquillo nel tempo che resta. La probabilità che sudi quando è spaventato è 0,85, che sudi quando corre è 0,99 e che sudi quando è tranquillo è 0,02. Qual è la probabilità che un cavallo sudato sia spaventato? [0,077053]

62) Andrea va al supermercato 1 volta alla settimana, Bruno 2 volte e Cristina 3. Non vanno mai nello stesso giorno. La probabilità che Andrea rubi è 0,3, che Bruno rubi è 0,05 e che Cristina rubi è 0,01. Qual è la probabilità che un furto sia colpa di Andrea? [0,697674]

63) In un campione in cui i giovani sono tanti quanti gli anziani e giovani e anziani sono tanti quanti gli adulti, un programma è visto dal 40% dei giovani, dal 20% degli adulti e dal 5% degli anziani. Qual è la probabilità che chi vede il programma sia adulto? [0,4706]

Fonte:

http://schedematematica.wikispaces.com/file/view/SCHEDE+SULLA+PROBABILIT%C3%80.doc

http://schedematematica.wikispaces.com/file/view/ESERCIZI%20SULLE%20PROBABILIT%C3%80.doc

Sito web da visitare :http://schedematematica.wikispaces.com/

Autore del testo: non indicato nel documento di origine

Parola chiave google : Probabilità tipo file : doc

Matematica geometria ragioneria e statistica appunti esercizi lezioni riassunti testi materiale didattico

Matematica scuola elementare , scuola media, scuola superiore e università

- Algebra

- Algebra di Boole

- Algebra monomi, binomi, polinomi

- Angolo solido

- Calcolo delle probabilità

- Circonferenza

- Circonferenza e cerchio

- Come si calcola la percentuale

- Come si calcola la percentuale di sconto

- Come si calcola una formula inversa

- Curve algebriche

- Definizioni di Euclide

- Disequazioni di secondo grado

- Elementi di euclide

- Equazioni

- Equazioni e disequazioni

- Eventi aleatori

- Formule area e perimetro figure piane

- Formule del volume

- Frazioni numeriche

- Funzioni goniometriche

- Geometria

- Geometria analitica

- Geometria definizioni

- Geometrie non euclidee

- Geometria razionale misura proporzionalità

- Geometria razionale nozioni fondamentali

- Geometria solida

- Geometria tesine

- Goniometria

- Goniometria lo studio degli angoli

- Integrali

- Le coniche

- Le quadriche

- Logica

- Luoghi geometrici

- Macchina di Turing

- Matematica algoritmi

- Matematica attuariale

- Matematica definizioni regole e teoremi

- Matematica domande e risposte

- Matematica e statistica glossario

- Matematica finanziaria

- Matematica matrici

- Matematica probabilità

- Matematica quiz

- Matematica storia e fondamenti

- Matematica teoria

- Matematici famosi

- Misura degli angoli

- Moltiplicazioni

- Monomi

- Notazione scientifica

- Nozioni di teoria degli insiemi

- Numeri naturali interi

- Numeri razionali

- Percentuali calcolo percentuale come calcolarle

- Poligoni regolari irregolari inscritti circoscritti

- Polinomi

- Potenze di 2

- Potenze di 3

- Potenze di 10

- Primo teorema di Euclide

- Principali teoremi della geometria

- Probabilità

- Prodotti notevoli

- Quadratura del cerchio

- Quiz di matematica

- Radicali esponenti frazionari e potenze

- Retta nel piano cartesiano formule

- Secondo teorema di Euclide

- Statistica

- Statistica appunti

- Statistica indici di dispersione media moda e mediana

- Statistica la distribuzione normale

- Statistica scarto quadratico medio

- Storia geometria

- Superfici di rotazione

- Tabellina dell' 1

- Tabellina del 2

- Tabellina del 3

- Tabellina del 4

- Tabellina del 5

- Tabellina del 6

- Tabellina del 7

- Tabellina dell' 8

- Tabellina del 9

- Tabellina del 10

- Tabellina del 11

- Tabellina del 12

- Tabellina del 13

- Tabellina del 14

- Tabellina del 15

- Tabellina del 16

- Tabellina del 17

- Tabellina del 18

- Tabellina del 19

- Tabellina del 20

- Tabelline di matematica da stampare

- Teoria dei numeri

- Tecniche di analisi dei dati

- Teorema di Lagrange

- Teorema di Pitagora formule e dimostrazione

- Teorema di Ruffini

- Teorema di Talete

- Test di geometria

- Test di logica

- Trigonometria formule e formulario

- Variabili casuali

Matematica geometria ragioneria e statistica appunti esercizi lezioni riassunti testi materiale didattico

Matematica scuola elementare , scuola media, scuola superiore e università

Visita la nostra pagina principale

Probabilità

Termini d' uso e privacy